eBook „Compiler-Welten“ Compiler-Infrastrukturen und ihre Geheimnisse

Performante Code-Ausführung erfordert einen leistungsstarken Compiler – oder mehrere. Bei dieser Entscheidung haben Entwicklerinnen und Entwickler ohnehin schon die Qual der Wahl. Die Konvergenz aktueller Trends stellt nebenbei noch bewährte Arbeitsabläufe auf den Kopf.

Das Aufkommen revolutionärer Programmierparadigmen und neuer Technologien geht auch an Compiler-Infrastrukturen nicht spurlos vorbei. Das Aufkommen von Künstlicher Intelligenz (KI) und Machine Learning (ML) wälzt gerade die Compiler-Szene um. Es verspricht, die Qualität und Performance von ausführbarem Code exponentiell zu steigern.

Zwei beeindruckende Werkzeuge, die diese Fusion von Alt und Neu verkörpern, sind der quelloffene ML-Compiler XLA (Accelerated Linear Algebra) von TensorFlow und TorchScript, eine Teilmenge von Python für den PyTorch JIT Compiler. Die Fähigkeiten dieser beiden Lösungen gehen über die reine Kompilierung hinaus. Das Resultat ist eine Kaskade von Leistungsverbesserungen und optimierter Ressourcennutzung.

Compiler spielen zudem eine Schlüsselrolle als Vermittler zwischen ML-Modellen und der Hardware, und adressieren auch leistungsarme Geräte an der Edge. Dieser Trend verstärkt die ohnehin schon fortgeschrittene Fragmentierung der Infrastruktur im Bereich des maschinellen Lernens über verschiedene Frameworks, Compiler und Laufzeiten hinweg.

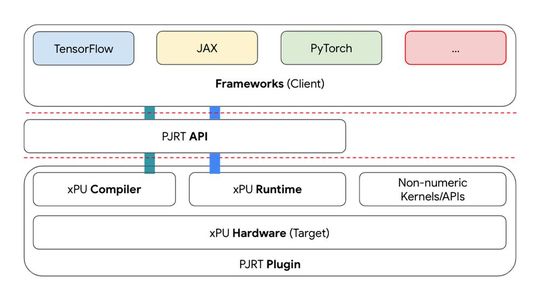

Diese Entwicklung erschwert die Integration von Toolchains. Quelloffene Projekte wie PJRT (Portable JIT Runtime) und MLIR (Multi-Level Intermediate Representation), eine Infrastruktur für ML-Compiler, wollen dieses Problem mildern.

Das MLIR-Framework will der explodierenden Komplexität der Softwareentwicklung im Bereich des maschinellen Lernens Einhalt gebieten, indem es die Kosten für den Aufbau von domänenspezifischen Compilern senkt, die Kompilierung für heterogene Hardware verbessert und die Optimierung der Leistung von ML-Modellen über ein breites Spektrum an Rechenumgebungen erleichtert.

Dieses revolutionäre Framework stellt einen bedeutenden Fortschritt in der Integration von hochentwickelten maschinellen Lernmodellen und anspruchsvollen Hardware-Optimierungen dar. Dank der Unterstützung seitens AMD, ARM, Intel, Nvidia, Qualcomm und anderer Marktakteure großen Kalibers kann MLIR bereits mehr als 95 Prozent der KI-Beschleuniger in Rechenzentren weltweit abdecken.

Mit seinen vielschichtigen Abstraktionsebenen bietet MLIR den Entwicklern und Entwicklerinnen die Möglichkeit, nahtlos zwischen algorithmischen Entwürfen und granularen Hardware-Anweisungen zu navigieren. Dies erleichtert wiederum die mühsame Aufgabe, die Leistung von ML-Modellen für verschiedene Rechenumgebungen zu optimieren.

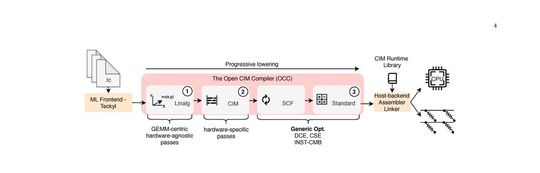

Auf dem Unterbau von MLIR entstand unter anderem der Open CIM Compiler (OCC), eine leistungsstarke Kompilierungsinfrastruktur und eine Suite von Tests für einen Computing-In-Memory- oder kurz CIM-Gerätesimulator am Center For Advancing Electronics der Technischen Universität Dresden.

KI/ML-gestützt optimieren und kompilieren

Durch die KI-gestützte Analyse großer Datenmengen lassen sich Zusammenhänge aus der realen Welt ableiten und die Nachwirkungen von Entscheidungen und anderen Ereignissen vorausschauend modellieren – auch in einem Compiler.

Die Forschung an Compilern läuft auf Hochtouren. Fortgeschrittene Techniken der Parallelisierungs- und Schleifenoptimierung, der Datenflussanalyse und Automatisierung von Compiler-Optimierungsaufgaben gewinnen immer mehr an Bedeutung unter Einbezug von Techniken des Tiefen Verstärkungslernens und anderer ML-Methoden.

Einige Forscher schlagen maschinelles Lernen vor, um Probleme der Compiler-Instabilität zu mildern und so effektivere Code-Optimierungen zu ermöglichen. Die Integration von KI/ML-Technologien in Compiler-Infrastrukturen soll nebenbei auch eine vorausschauende Fehleranalyse ermöglichen. Projekte wie OCC und Apache TVM haben schon in dieser Hinsicht einiges vollbracht.

- Der Open CIM Compiler erweitert eine Compiler-Infrastruktur um eine Sammlung von Tests für einen CIM-Gerätesimulator (kurz für Computing-In-Memory), um mehrstufiges IR-Rewriting zu ermöglichen.

- Der TVM-Compiler (Tensor Virtual Machine) führt ausgefuchste Optimierungen auf Graphen- und auf Operator-Ebene durch, um die Leistungsfähigkeit von Deep-Learning-Workloads auf verschiedenen Hardware-Backends zu gewährleisten. Es kompiliert Deep-Learning-Modelle in minimale, bereitstellungsfähige Module (Engl. minimum deployable modules); diese lassen sich sehr effizient auf verschiedenen Hardwareplattformen ausführen, von CPUs über GPUs, FPGAs bis hin zu einem Webbrowser. TVM macht sich unter anderem ML-basierte Optimierungen zu Nutze, um in einem großen Suchgefilde von OpenCL-Kernels die leistungsstärksten Implementierungen ausfindig zu machen.

Compiler für probabilistische Programmierung

Probabilistische Programmierung zielt darauf ab, Software zu erzeugen, die mit Unsicherheit und Wahrscheinlichkeiten umgehen kann (Stichwort: ML auf leistungsschwacher Edge-Hardware). Probabilistische Modelle machen sich eine Zufallsstichprobe von Werten aus Wahrscheinlichkeitsverteilungen zu Nutze, konditionieren die beobachteten Daten und führen auf dieser Basis die Inferenz durch. Der Ansatz bewährt sich in KI-nahen oder KI-getriebenen Anwendungsszenarien in der Finanzbranche, im Gesundheitswesen, in der Bioinformatik und in der Cybersicherheit.

TensorFlow Probability (TFP) ist ein Beispiel für eine Bibliothek, die probabilistische Programmierung in einem Tensor-Fluss-Computing-Framework integriert. TFP nutzt TensorFlows Fähigkeiten zur automatischen Differenzierung, um probabilistische Modelle zu optimieren und Inferenz zu ermöglichen. Sie erweitert Compiler-Infrastrukturen und Laufzeitumgebungen, um Unterstützung für probabilistische Programmierung zu gewährleisten.

Compiler (und Laufzeitumgebungen) für probabilistische Sprachen müssen mit spezialisierten Optimierungen für statistische Modelle aufwarten. Probabilististische Programmierung spielt sich hauptsächlich in domänenspezifischen Sprachen wie Pyro, Stan und Church ab. Compiler-Infrastrukturen für probabilistische Programmierung müssen zur Durchführung hochspezialisierter Optimierungen unter anderem erweiterte Typsysteme und automatische Differenzierung beherrschen.

Quantenprogrammierung und -kompilierung

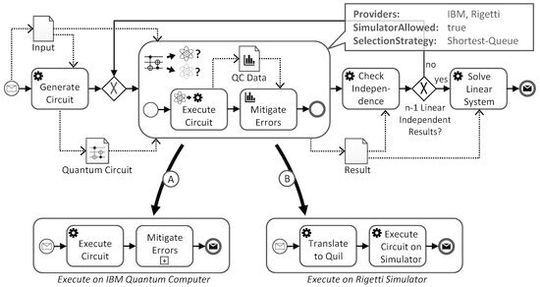

Quantencomputer können bestimmte Probleme bekannterweise schneller lösen als klassische Systeme, indem sie sich die Prinzipien der Quantenmechanik zu Nutze machen.Quanten-Programmierer entwickeln Quantenalgorithmen als Quantenschaltkreise, bestehend aus Quantengattern, Schaltern, Operatoren und dergleichen anderen Komponenten.

Quantenkompilierer transformieren hochstufige Quantenalgorithmen in ausführbare maschinelle Anweisungen für spezifische Quantenprozessoren. Sie übersetzen hierzu High-Level-Quantenalgorithmen (zum Beispiel aus Quantum Assembly Language, QASM) in die sogenannten Quantenbefehlssätze für eine ganz bestimmte Quantenarchitektur (Engl. quantum instruction sets). Erst diese kompilierten, niedrigstufigen Anweisungen lassen sich dann auf einem bestimmten Quantenprozessor ausführen.

Quantenkompilierer analysieren und optimieren den Quantenschaltkreis für die Ausführung auf der betreffenden Quantenhardware. Da Qubits für Rauschen und Dekohärenz anfällig sind, müssen sie auch spezielle Quantenfehlerkorrekturen durchführen.

Klassische Compilerinfrastrukturen auf dem Weg in eine (ungewisse) Zukunft

In der Zwischenzeit müssen auch althergebrachte Compiler-Infrastrukturen mit der Zeit gehen und neue Programmierparadigma angemessen unterstützen – zum Beispiel reaktive Programmiermuster.

Die meisten traditionellen Compiler von Hochsprachen wie C++, Java oder Python – darunter GCC und Clang/LLVM – sind primär darauf ausgerichtet, statischen Code in Maschinencode oder Bytecode zu übersetzen, ohne dabei spezifisch auf reaktive Muster oder asynchrone Datenflüsse Rücksicht zu nehmen.

Die Reaktive Programmierung ging aus der Erkenntnis hervor, dass Software auf Änderungen in Datenströmen und andere Ereignisse reagieren könnte (oder besser gesagt: sollte), ohne explizit für jedes erdenkliche Szenario programmiert zu werden – alles Andere wäre natürlich Schnee von gestern.

Dieser Ansatz bewährt sich insbesondere in Anwendungen, die in Echtzeit eine Vielzahl von unvorhersehbaren Datenaktualisierungen handhaben müssen. Komplexe Benutzerschnittstellen in Web- oder sonstigen Anwendungen sind nur ein Beispiel von vielen.

Reaktive Programmierung und die Verwaltung von Datenströmen werden typischerweise durch Bibliotheken oder Laufzeitumgebungen bereitgestellt. Einige der bekanntesten Bibliotheken und Frameworks für die reaktive Programmierung sind RxJava für Java, Reactor für die JVM, ReactiveX für verschiedene Sprachen (wie RxJS für JavaScript) und Akka Streams für Scala und Java.

Gewisse Sprachfeatures und die zugehörigen Compiler-Fähigkeiten können die Entwicklung reaktiver Anwendungen erleichtern, darunter:

- Asynchronität und nicht blockierende E/A-Operationen (Engl.: asynchrony and non-blocking IO): Sprachen, die native Unterstützung für Asynchronität bieten (z.B. durch async/await in C# und JavaScript oder Coroutines in Kotlin) vereinfachen die Implementierung reaktiver Logik.

- Funktionale Programmierkonzepte: Programmiersprachen mit ausgereifter Unterstützung für Konzepte wie die Unveränderlichkeit (Engl.: immutability) und Funktionen höherer Ordnung (Engl.: higher-order functions, z.B. map, filter, reduce) wie Scala, Kotlin oder JavaScript schaffen eine geeignete Basis für reaktive Programmiermuster.

- Typsystem: Ein starkes, ausdruckfähiges Typsystem erleichtert die Entwicklung reaktiver Anwendungen, insbesondere wenn es um die Handhabung komplexer Datenstrukturen und die Vermeidung von Fehlern geht; Konzepte wie Typinferenz und Generics unterstützen die Erstellung flexibler und wiederverwendbarer reaktiver Abstraktionen.

- Metaprogrammierung und Annotationsverarbeitung: Einige reaktive Frameworks erleichtern gezielt das Erstellen von Boilerplate-Code zur Laufzeit oder zur Kompilierzeit, was die Entwicklung vereinfacht und die Performance verbessern kann.

- Laufzeitumgebung und JIT-Optimierungen: Während dies nicht direkt eine Anforderung an den Compiler darstellt, ist eine Laufzeitumgebung, die JIT-Kompilierung (Engl. Just-In-Time) oder ähnliche Optimierungstechniken unterstützt, eine wichtige Voraussetzung dafür, um die Performance reaktiver Anwendungen zu maximieren. Insbesondere jene reaktiven Anwendungen, die eine große Menge an kleinen, asynchronen Aufgaben verarbeiten, ziehen großen Nutzen aus JIT-Optimierungen.

Die besten Compiler für Reaktive Programmierung gehen über diese Features hinaus.

Fazit

Vor dem Hintergrund dieser umwälzenden Trends durchläuft die Compiler-Szene tiefgreifende Veränderungen. Das wachsende Interesse an innovativen Compiler-Infrastrukturen stellt die ganze Dev-Landschaft auf den Kopf. Developer „stimmen mit den Füßen ab“: Auf der Suche nach der besten Toolchain betreten sie auch in Sachen Compiler, wohl oder übel, unerforschtes Terrain – mehr dazu im eBook „Compiler-Welten“.

(ID:49969818)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/c4/e1c4431ac5dfcafb19898bd5725a9f14/0117218868.jpeg)

:quality(80)/p7i.vogel.de/wcms/c1/ef/c1ef57469c8313b8d619072b1f5b3d5d/0117974880.jpeg)

:quality(80)/p7i.vogel.de/wcms/0e/e4/0ee4b6dbf2d232a6b8f745cb451eddd6/0117778844.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/07/680732474677c5a28643837723c1fd6f/0117804372.jpeg)

:quality(80)/p7i.vogel.de/wcms/fc/45/fc456bcbbe62b98f668c2b870cd05568/0117785924.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/04/5204001045d6084687e6d1e51b7f6165/0117560791.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/e9/afe9b9de753a728e78e7d87781679258/0116428271.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/d5/9fd50297852b420bfe284cfdb0d8b951/0117862443.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/db/9cdb5a28bedea470a6baaa13acbf895f/0117837156.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/6d/f76d249a97c8c0a91983ab137df5a078/0117977628.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/11/a8113a6079bb96bc882fc76fa42fd3cb/0117188398.jpeg)

:quality(80)/p7i.vogel.de/wcms/49/dc/49dcc2742caf67b30a9c62e1487c02ec/0117894631.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:quality(80)/p7i.vogel.de/wcms/68/07/680732474677c5a28643837723c1fd6f/0117804372.jpeg)

:quality(80)/p7i.vogel.de/wcms/6e/a8/6ea8547b0fb110921fb8b4b40e9c7eb9/0114132511.jpeg)