Von Loki bis Azimuth OpenInfra zwischen lähmendem Erfolg und ungelösten, neuen Aufgaben

So sieht Erfolg aus: Die OpenInfra Foundation umfasst eine Community von 110.000 Personen aus 187 Ländern. Das wichtigste Projekt ist nach wie vor „Openstack“ auch wenn sich etwa „StarlingX“, „Kata Containers“ und „Swift“ mausern. Doch wie sieht die Zukunft der Open-Source-Projekte aus? Besucher des Vancouver „OpenInfra Summit“ entwickeln die Projekte stetig weiter, aber neue gab es nicht zu verkünden und erst recht keine bahnbrechenden.

Es war der 22. OpenInfra-Summit, wenn man ihn als den Nachfolger des „OpenStack-Summit“ durchgehen lässt, und der dritte in Vancouver. 2010 startete das Projekt OpenStack und 2015 machte der Summit hier das erste Mal Station.

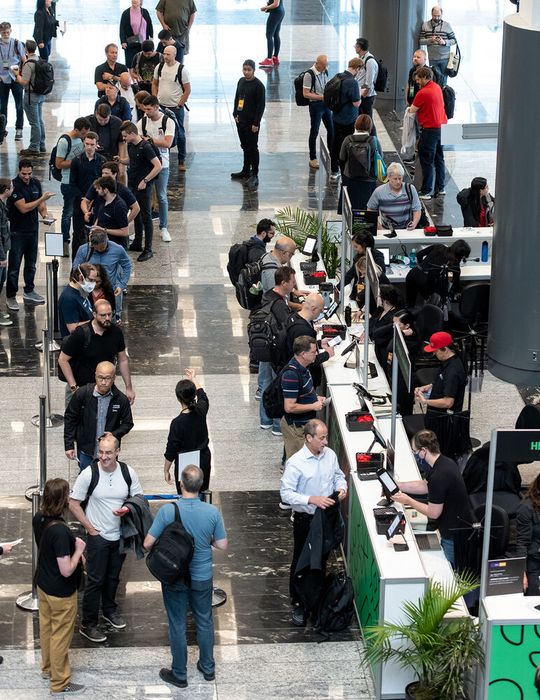

Doch was für ein Unterschied: Waren 2015 Tausende vor Ort, sind es heuer noch rund 750 gewesen, so der Veranstalter; die meisten davon haben zugleich auch Vorträge oder Übungs- und Diskussionsrunden geleitet. Damals waren zwei OpenStack-Releases im Jahr noch zu wenig, heute gibt es nur noch eins. Damals gab es Sponsoren in Mengen, heuer nicht einmal einen Sponsor für das Mittagessen der Teilnehmer – 2019 stellte etwa Suse seine „OpenStack Cloud“ ein. Damals wollte man seitens der Foundation die Entwickler separieren, um mehr Ruhe in die Entwicklungen zu bringen, und heute? Sie stecken wohl zumeist in Cloud-Native- respektive Kubernetes-Projekten.

Dabei gehörte Kubernetes zu den Projekten, die durch OpenStack angestoßen wurden und von Beginn an starke Unterstützung fanden. So hat Thierry Carrez, Geschäftsführer, OpenInfra Foundation, in seinem Part der Keynote die Entwicklung der OpenOnfra wie folgt überrissen: „Angefangen mit OpenStack, der ersten Cloud mit universellem Fokus; führte zum Aufstieg anderer Projekte wie ‚Ceph‘, ‚OpenvSwitch‘, ‚KVM‘ und Kubernetes; dazu kamen Kata Containers und StarlingX – Lösungen, die zwischen Hardware und Anwendungen angesiedelt sind.“

Das gemeinsame Ziel beschreibt er unter den Stichworten Open Source, Infrastruktur und Standardisierung: Open Source bedeute in erster Linie quelloffen, sowie das Schaffen gesunder, „nachhaltiger Gemeinschaften, die langlebige Infrastruktursoftware produzieren.“ Infrastruktur geht über Openstack hinaus, ist „programmierbare Infrastruktur, auf der Anwendungen laufen und auf der Innovationen möglich sind“, mithilfe von Standardisierungen, die zugleich eine offene Zusammenarbeit bei gemeinsamen Lösungen ermöglichen aber auch deren sowie Monetarisierung und Differenzierung.

Die Erfolge

„Wir haben es geschafft“, so Carrez. Er zählt auf:

- Aus 150 Community-Mitgliedern sind 110.000 geworden.

- OpenStack hat 40+ Millionen Kerne und wächst schnell weiter.

- Kata-Containers, im Wesentlichen eine Hypervisor-basierte Isolierung pro Container-Pod, sichert Container-Workloads bei der Ant Group und den größten Zahlungsabwickler der Welt, Alipay, der täglich mehr als 100 Millionen Zahlungen pro Tag verarbeitet und wird von mehr als 1 Milliarde Nutzern verwendet.“

Doch es gebe noch mehr zu erforschen, zum Beispiel Software zur Integration neuer Hardware-Funktionen, etwa GPUs, Verschlüsselung und das An- und Abschalten von Kernen um Strom zu sparen, sowie mehr Open-Source-Komponenten in proprietären Cloud-Stacks. Jüngstes Beispiel ist die Integration von Kata Containers in das „Azure“-Angebot von Microsoft (siehe Kasten: „Kata Containers in AKS“).

Kennen Sie Loki?

Loki ist eine Figur aus der nordischen Mythologie, ein Ase. Wikipedia leitet den Namen „Loptr“, was altnordisch „der Luftige“ oder „Luftgott“ bedeutet. Dieser Ausdruck ist jedoch eher im Sinne von „Luftikus“ zu verstehen. Im Umfeld von OpenInfra allerdings ist die Bezeichnung ein Akronym aus Linux, OpenStack, Kubernetes-Infrastruktur. Das Cern etwa benutzt Loki zur Verarbeitung von Forschungsdaten in etwa 300.000 Kernen, die von OpenStack, hier als Datacenter-Betriebssystem, und insbesondere von „OpenStack Magnum“ für K8s-Cluster verwaltet werden.

Auch China Telecom nutzt Loki in über 700 Rechenzentren. Bloomberg – das Unternehmen erhielt in diesem Jahr den OpenInfra-End-User-Preis – stellt Nachrichten und Finanzinformationen mithilfe von 400.000 Kernen und OpenStack, Hunderten von Bare-Metal- und virtuellen K8s-Clustern dar.

StarlingX feiert den 5. Geburtstag

Wenn sich die Infrastruktur von einem einzelnen Computer oder Datacenter zu einem geografisch verteilten System entwickeln muss, kommt StarlingX ins Spiel. Das OpenInfra-Projekt hat die Komponenten des Loki-Stacks, fusioniert diese Elemente und fügt fehlende Teile hinzu, um wichtige Infrastrukturen außerhalb der Rechenzentren bereitzustellen. Aus der Taufe gehoben wurde StarlingX bei einem Summit in Vancouver vor fünf Jahren.

Wie Jeff Gowan, Marketing Director bei Wind River, dem Hauptsponsor des Summit 2023, ausführt, soll StarlingX die Infrastruktur für die nächste Generation von Cloud Native sein. Während OpenStack die Infrastruktur für die Bereitstellung von virtuellen Maschinen in großem Umfang bietet, „Es hat uns geholfen zu realisieren, was vor zehn Jahren noch als Science-Fiction gegolten hat“, so Gowan, stoße das Projekt in einer Welt selbstfahrender Autos, immer- und überall verfügbarer Konnektivität, Drohnen und Intelligenter Städte an seine Grenzen.

„Zum Glück“, sagt Gowan, „kam 2014 Kubernetes auf den Markt. Kubernetes ist für massiv verteilte Systeme“ – geografisch verteilt, Tausende von Systemen, Unterstützung für Container und virtuelle Maschinen von Anfang an, hochleistungsfähige Lösungen in Bezug auf Latenz und Betriebszeit, einfache automatisierte Bereitstellung, operative Benutzerfreundlichkeit wie zentralisierte Verwaltung und automatische Updates. „Das Rechenzentrum sieht anders aus. Jetzt hat es vielleicht Räder oder Flügel, wie bei einem Auto oder einem Düsenjäger.“

Für Leser beziehungsweise Hörer, die Podcast lieben, haben Elke Witmer-Goßner, Chefredakteurin von CloudComputing-Insider, und Ulrike Ostler, Chefredakteurin von DataCenter-Insider, einen Kommentar zum OpenInfra Summit aufgenommen.

Die Podcast-Folge #15 von DataCenter Diaries „Elke fragt, Ulrike antwortet: Kommentar der DataCenter-Insider-Chefredakteurin zum OpenInfra Summit 2023“ findet sich auf Spotify, Apple Podcasts, Deezer, Amazon Musik und Google Podcasts.

Gowan setzt hinzu: „Wenn wir nur aus der Perspektive eines Rechenzentrums denken, werden wir buchstäblich in die Enge getrieben und sind nicht in der Lage, die neuen Anwendungsfälle und Anforderungen zu erfüllen.“ Die verteilten Standorte sollten seiner Ansicht nach als Clouds und Sub-Clouds in einem verteilten System betrachtet werden und nicht als separate, eigenständige Einheiten.

Um fünf, zehn oder 1.000 Standorte zu verwalten, von denen jeder seine eigenen Anforderungen in Bezug auf Software-Installationen, Updates, Versionskontrolle, Verfügbarkeit, Betriebszeit, Lastausgleich und Disaster Recovery hat, müsse man sie als Kollektiv betrachten. StarlingX löst Aufgaben wie:

- Wie sind alle Standorte auf dem neuesten Stand zu halten und auf dieselbe Version zu synchronisieren ohne den Dienst zu unterbrechen?

- Wie sieht es mit dem Sicherheits-Management aus?

- Wie wird die Orchestrierung aller erforderlichen Updates und Anwendungen unterstützt?

- Sobald eine Lösung implementiert ist, wie lässt sich dann skalieren?

Zu Letzterem bringt Gowan ein Beispiel aus dem eigenen Unternehmen: In den vergangenen zweieinhalb Jahren habe Wind River sein „Studio“ mithilfe von Verizon 5G auf 10.000 Standorte, Tendenz steigend, ausgeweitet. Er macht zudem deutlich, wie dringend neben der Skalierung Echtzeit in diesem Umfeld ist: „Was auch immer es ist, die verteilte Cloud-Technologie wird Folgendes ermöglichen:

- Verfolgung von Vermögenswerten in Echtzeit mit Hilfe von Trackern, Sensoren, Kameras, Verkehrsströmen, Luftraum, usw.

- Vorausschauende Wartung durch Anwendung von Algorithmen des maschinellen Lernens zur Vorhersage, um Ausfälle vorherzusagen und sie zu beheben, um Ausfallzeiten zu begrenzen.

- Fernüberwachung von Flotten, Optimierung von Routen und Reduzierung von Treibstoffkosten.

- Einsatz von mobilen Anwendungen.

- Datenanalyse und -verarbeitung zur Verbesserung des Betriebs.

In all diesen Anwendungen werde sie benötigt. StarlingX und die jüngsten „Intel-Xeon“-Prozessoren harmonierten bereits; ARM sei vor Kurzem der StarlingX-Community beigetreten.

Die Zukunft mit generativer KI

Spricht Gowan auch von Anwendungen in verteilten Umgebungen, die erst noch „erfunden“ werden (müssen), ist das ganz sicher im Umfeld generativer Künstlicher Intelligenz der Fall. Wie auch im Cloud-Native-Umfeld steht die OpenInfra-Foundation quasi unter Schock, wenn es um die Veröffentlichung von „ChatGPT“ durch OpenAI geht. Der Nvidia-Chef spricht vom „iPhone-Moment“ der Künstlichen Intelligenz.

Die Open-Source-Welt hat diesem noch nicht wirklich etwas entgegen zu setzen; eigentlich dürfte der geneigte Anwender von der OpenInfra Foundation einiges erwarten, ist in diesem Umfeld Infrastruktur ein mehr als bedeutsames Momentum. Der Betrieb von ChatGPT soll rund 500.000 Dollar pro Tag kosten. Welches Unternehmen kann sich das leisten?

Nun zumindest hat Mark Collier, COO der OpenInfra Foundation das Thema auf die Keynote-Bühne gebracht. „Der Markt für künstliche Intelligenz wird bis 2030 auf 1,5 Billionen US-Dollar anwachsen, und jedes große IT-Unternehmen baut seine eigene KI-Strategie auf.“ Und seiner Einschätzung nach sind die Voraussetzungen für den Einsatz von Open-Source-Techniken, im Zweifelsfall verbandelt mit OpenInfra-Technologien gar nicht so schlecht.

Collier zitierte ein berühmt gewordenes Google-Leck: „Aber die unbequeme Wahrheit ist, dass wir nicht in der Lage sind, dieses Wettrüsten zu gewinnen und OpenAI ist es auch nicht. Während wir uns gestritten haben, hat eine dritte Fraktion still und leise unser Mittagessen gegessen.“

Collier kommentiert weiter: 1,5 Billionen ist eine Menge zu essen. Ich für meinen Teil hoffe, dass die Open-Source-Fraktion in den kommenden Jahren gut essen wird.“ Open-Source-Modelle seien schneller, anpassungsfähiger, privater und fähiger. „Sie können mit 100 US-Dollar und 13 Milliarden Parameter mehr Dinge tun, als wir mit 10 Millionen US-Dollar und 540 Milliarden Parameter. Und sie tun dies in Wochen, nicht in Monaten.“

Open Source und KI

Collier: „Vor 3 Monaten dachten wir, dass nur Unternehmen mit Milliarden von US-Dollar diese Modelle herstellen könnten, und jetzt reduziert Open Source das auf Laptops mit einer GPU. Die disruptive KI ist bereits disruptiv.“ Anders als die Sprecher der CloudNative Computing Foundation auf der „KubeCon/CloudNativeCon“ in Amsterdam vor Kurzem, sieht Collier bereits eine glänzende Zukunft der generativen KI in der Software-Erstellung voraus: „Eine der unmittelbarsten Auswirkungen von KI ist die Art und Weise, wie Code erstellt wird.“

Doch ganz ohne Warnung kommt auch er nicht aus: „Einige Entwickler machen sich das zunutze, aber die Wahrheit ist, dass wir noch nicht wissen, welche langfristigen Auswirkungen auf die Art und Weise, wie Software produziert wird.“ Allerdings gebe es schon erste Auswirkungen. So schlage sich die Python-Community bereits mit Code-Reviews von KI-generiertem Code herum.

Angst vor KI und Angst vor Regulierung

Und es gehe Angst um. Beispielsweise versuchten Regierungen, KI zu regulieren. „Dies ist einer der Gründe, warum wir OpenInfra Asia und OpenInfra Europe gegründet haben“, sagt Collier (siehe Kasten: „OpenInfra Foundation gründet regionale Zentren in Asien und Europa“)

Nvidia und Graphcore an Bord

Für den Erfolg von Open-Source-Infrastruktur und Aufgaben wir große KI-Modelle in adäquater Zeit zu rechnen, ist es ganz sicher nicht schlecht, den Marktführer in Sachen Accelerated Computing an Bord zu haben: Nvidia unterstützt etwa das Objektspeichersystem Swift. Aber auch das Unternehmen Graphcore, das Hardware-Architekturen und -Beschleuniger für KI-Rechenlasten baut, hat auf dem Summit eine bedeutsame Rolle eingenommen.

Eines der Probleme, die es zu lösen gilt, ist dass die Datensätze so groß werden, dass sie in keinen GPU-Speicher passen, nicht einmal in den Flash-Speicher der Rechner. Objektspeicher hingegen sind prädestiniert für riesige Datenmengen, brauchen aber andere APIs.

Graphcore bietet über „BOW-2000 Intelligence Processing Unit“ zwar Beschleunigung für KI und ML-Anwendungen, will aber die eher händische Verwaltung loswerden und experimentiert mit virtuellen Pods sowie „Azimuth“-Schnittstellen.

Und dann wäre noch Security

Jonathan Bryce, Geschäftsführender Direktor der OpenInfra Foundation, der heuer mit seinem Neugeborenen die Bühne betreten hat, stellt zunächst einmal klar, worum es in der OpenInfra-Community eigentlich geht, angesichts der immer weiter steigenden Gefahr, den immer subtileren Angriffsmethoden und der zunehmenden Komplexität der Angriffsabwehr: „Es geht um die Schichtung verschiedener Tools und Techniken, die sich weiterentwickeln, weil sich die Systeme an eine dynamische Bedrohungslandschaft anpassen.“

Neben Kata Containers spielen auch Software-Lieferketten (SBOM) eine Rolle. Doch Letzteres ist laut Aeva Black, Open-Source-Hacker und Sekretärin des Verwaltungsrats, Open Source, mit Vorsicht zu genießen. Denn die Modellierung von kommerziellen Lieferketten von physischen Gütern ist das Vorbild und die Übertragung auf Open Source könne zu „katastrophalen Ergebnissen bei Open-Source-Projekten führen, bei denen die Haftung ausdrücklich abgelehnt wird.“

Sie verweist auf eine Aussage des Office of the National Cyber Director: „Die Verantwortung muss bei den Akteuren liegen, die am ehesten in der Lage sind, Maßnahmen zu ergreifen – nicht auf den Open-Source-Entwicklern.“ Sie folgert: „In den USA versucht die derzeitige Regierung, die Integrität der Open-Source-Gemeinschaften zu bewahren. Doch die EU verfolgt möglicherweise einen anderen Ansatz.“

Wie auch immer, seien SBOMs auf dem Vormarsch und die derzeitigen Mindestanforderungen niedrig. Doch das ändere sich bereits. Ihr Tipp: Foundations sollten die Messlatte von vorneherein höher legen aber zugleich mit anderen zusammenarbeiten, um bei Regierungen für Ausgewogenheit der Vorschriften einzutreten.

Aufkommende Tools in diesem Umfeld sind:

- SLSA + S2C2F.

- OmniBOR – hier ermöglichen ein automatischer Aufbau eines Artefakt-Abhängigkeitsgraphen und das Einbetten von Graph-Identifikatoren in binäre Artefakte die Rückverfolgbarkeit der Lieferkette ohne Änderungen auf Projektebene.

- HipCheck.

- GUAC.

- Sigstore.

- OpenSSF – Supply-chain Levels for Software Artifacts, ein Standard zur Bewertung sicherer OSS-Entwicklungspraktiken.

- ScoreCard.

- MITRE HipCheck – automatisierte Risikobewertung auf der Grundlage von Community-Entwicklungspraktiken erweitert statische Analysen, Abhängigkeitsüberprüfungen und CVE-Scanner.

Übrigens: Ein neuer Termin für einen OpenInfra Summit 2024 wurde nicht bekannt gegeben.

(ID:49634749)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/dc/80dc01258b6dda1e7b216323d5796051/0118518397.jpeg)

:quality(80)/p7i.vogel.de/wcms/b5/92/b592b98f6fa8f4d5393e7d1f26a9b1ab/0117932513.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/88/af88b8b06a9613b86559b6999ef4ed8a/0118097195.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/b3/8eb34e2abe20465041e396063e8d39b5/0118088468.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/59/d859a4bcea4e775772b78767789646e7/0117717484.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/c5/eec54cec9c7a219a3ed62042db71e084/0118151065.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/9d/f19deb033fc3094112887ccba347e548/0118171860.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/2e/72/2e7289e13f9938285540e96be53cc098/0117654091.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/85/5b853b09ae4f974cb97b58e5cb8e759b/0118249571.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/3d/a83d193abb5ef91d666c1e785facf293/0114675276.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/ea/0dea35183fc5bd655d77db90d56ef41f/0112565568.jpeg)