Suse für die Edge Open-Source-Automatisierung bis zum Netzwerkrand

Anbieter zum Thema

Wie vereinfacht und automatisiert man das Management von Edge-Datacenter? Wie funktioniert deren nahtlose Einbindung in übergreifende Infrastrukturen? Mit einem auf „SLE Micro“ aufbauenden Stack hat Suse hierfür einen Vorschlag.

Edge-Computing gehört zu den großen Trends der Digitalisierung: Der Markt für Edge Datacenter hatte laut Grand View Research 2022 ein Volumen von 9,36 Milliarden Dollar und soll mit jährlich 18.4 Prozent wachsen.

Marketsandmarkets benennt das Marktvolumen 2023 mit 10,4 Milliarden Dollar und das 2028 mit 29,6 Milliarden Dollar. Meticulous Research sieht ein Volumen von 46,4 Milliarden Dollar 2030 und spricht gar von einer Wachstumsrate von 20,9 Prozent zwischen 2023 und 2030.

Es ist also keinesfalls unerheblich, welche Technologien, Produkte und Konzepte dort eingesetzt werden. Und so bringen sich die diversen Infrastrukturanbieter in Position, um diese vielversprechende Ressource anzubohren.

Herausfordernde Bedingungen

Die Bedingungen an der Edge sind herausfordernd: unterschiedliche Datenformate und Protokolle, eventuell Feuchte, Hitze, Dreck, Vibrationen, schlechte Zugänglichkeit. Trotzdem sollen die Datenwege zwischen den einzelnen Endkomponenten, dem Edge Datacenter und einer zentralen Cloud möglichst durchgängig sein.

Für die Edge Datacenter wünscht man sich möglichst automatische Konfigurier- und Reparierbarkeit. Das umfasst auch das Monitoring und Logging aller Standorte, wobei die Daten in einen Stream einfließen sollen.

Ziel ist eine umfassende Orchestrierung des gesamten Edge. Dazu gehört auch ein sinnvolles Lebenszyklus-Management der dort verwendeten Komponenten und Workloads. Und selbstverständlich darf das alles nicht auf Kosten der Sicherheit gehen.

Linux für die Edge

Eine wichtige Rolle wird am Edge auf jeden Fall auch Linux mit seinen diversen Derivaten spielen. So hat beispielsweise Suse Software Solutions (Suse) inzwischen ein umfassendes Konzept entwickelt, mit dem der Edge-Markt adressiert wird. Dabei peilt der Linux-Spezialist besonders die Branchen Automotive, Telco, Medical, Retail und produzierende Unternehmen an.

Im Mittelpunkt der Suse-Strategie für eine weiterentwickelte Edge (Edge 3.0) steht der möglichst vollständige Übergang auf Container und Kubernetes sowie ergänzende Suse-Angebote („Suse Manager“ (Suma) und Suma/„Rancher“. Darunter folgt die Container-Runtime und als Basis eine spezielle Variante von „Suse Linux Enterprise“, SLE Micro. Dabei soll „Rancher Prime“ alle Kubernetes-Distributionen managen.

SLE Micro als Basis

Derzeit gängig ist ein Stack aus SLE Micro, „KVM“ und darauf entweder einem Windows- oder Suse-basierenden Stack. Dadurch sei, so Suse in einer technischen Informationsveranstaltung im Web, nur eine partielle Orchestrierung der Lebenszyklen möglich. In der nächsten Version soll das anders werden.

Der Vorschlag für die Betriebssystem-Ebene: SLE Micro, sei leichtgewichtig und nach Installation unveränderbar. Das heißt: Nachträgliche Veränderungen verschwinden bei Neustart wieder. Das Dateisystem erlaubt nur Lesen. Updates werden transaktional durchgeführt, und zwar atomar, also vollständig oder gar nicht. Zudem kann man stets zum vorherigen Snapshot zurückgehen, wenn etwas schief geht.

SLE Micro ist modular und bringt viele Sicherheitsfunktionen mit. Es kann über Profile weiter gehärtet werden. Container und Mikroservices werden breit unterstützt. Über das Rancher-Dashboard lässt sich SLE Micro am Edge bereitstellen.

Möglich sind Standalone-Applikationen, Embedded-Systeme oder Managed-Edge-Datacenters respektive -Appliances. Beim Managed Edge verwaltet Suse Manager SLE Micro, bei Appliances übernimmt das Rancher Prime.

Kubernetes-Varianten

Suse empfiehlt für die Edge die von Rancher als CNCF (Cloud Native Computing Foundation)-Projekt entwickelte leichtgewichtige Kubernetes-Variante „K3s“. Sie lässt Produktions-Workloads auf Appliances am Netzwerk ablaufen, kommt als eine einzige Binärdatei und ist für ARM und x86 optimiert.

Für besonders sicherheitssensitive Applikationen empfiehlt Suse sein „RKE2“, eine gehärtete Edge-Variante des Container-Orchestrierers mit FIPS 140-2-Compliance. Darin stecken viele Betriebs-Management-Funktionen aus K3s. Die Software unterstützt aber mehr Netzwerk-Backends.

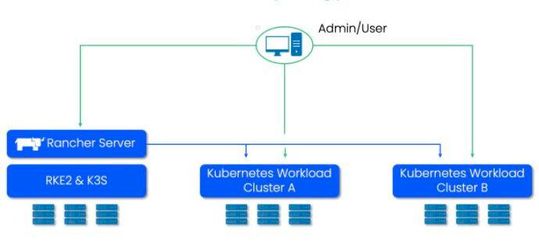

Mehrere Kubernetes-Cluster mit Rancher verwalten

Auch Umgebungen mit vielen Kubernetes-Clustern soll Rancher zuverlässig managen. Die Grundidee ist dabei, dass Rancher das einzige Tor zu Kubernetes bildet.

Über die Nutzerschnittstelle sind nur Aktionen möglich, die das Kubernetes-API – bereitgestellt durch Rancher – erlaubt. Rancher seinerseits fragt regelmäßig den Status der K8s-Endpunkte ab, um ein konsistentes Systemabbild zu garantieren.

Zu den Funktionen gehören zentrale Authentisierungsmechanismen, Zugriffs-Management und eine konsistente Regeldatenbank. Über einen bereits existierenden Authentisierungs-Provider lassen sich alle Kubernetes-Umgebungen integrieren.

Weniger Aufwand durch zentrale Rancher-Funktionen

Aufbauend auf den rollenbasierten Zugriffsmechanismen von Kubernetes managt Rancher auch die Zugangskontrolle, Sicherheits- und Netzwerkregeln zentral. Multi-Tenant-Cluster lassen sich als Rancher-Projekte verwalten.

Der Betriebsaufwand von Kubernetes sinkt durch zentrales Rancher-Lebenszyklus-Management aller Cluster einschließlich Skalierung, Upgrades oder Disaster Recovery. Auch Cloud-gehostete Kubernetes-Varianten wie „AWS EKS“ werden mit automatisiert und verwaltet genau wie Services von Drittanbietern. Für letztere gibt es ein spezielles API.

Continuous Delivery mit Fleet

Continuous Delivery wird über die Rancher-Funktion Fleet garantiert. Fleet verwaltet Kubernetes-Cluster auf allen Arten von Infrastruktur. Damit lassen sich auch Geräte mit instabilen Verbindungen hinter einer Firewall einbinden. Ein 'Fleet Manager Cluster' bündelt diverse Cluster zu Cluster-Gruppen mit gleichen Anforderungen, was den Verwaltungsaufwand verringert.

Der Onboarding-Prozess wird durch neue Rancher-Dienste erheblich vereinfacht: Der Admin entwickelt ein entsprechendes Image, mit dem die einzubindenden Maschinen im Hintergrund booten. Sie registrieren sich anschließend in der Inventardatenbank mit ihrem TPM-Hash.

Dann werden den Maschinen Rollen und einem Cluster zugewiesen, der anschließend mit Kubernetes geschaffen wird und sofort betriebsbereit ist. Mit Hilfe von „Rancher Fleet“ lässt sich auch der Lebenszyklus des Betriebssystems auf ähnliche Weise erheblich vereinfachen.

Discovery mit Akri

Die demnächst zu erwartende Komponente „Akri“ soll alle Arten von Edge-Endgeräten, egal über welche Netzverbindung, finden. Sie ist eine von mehreren wertsteigernden Edge-3.0-Komponenten aus dem Hause Suse. Dazu gehören auch das Sicherheits-Tool „Neuvektor“, persistentes „Longhorn“-Storage und „Harvester“ als leichtgewichtiges HCI.

Dabei sitzen Akri-Komponenten sowohl auf der Kontroll- als auch der Worker-Ebene von Kubernetes-Umgebungen. Akri befindet sich derzeit im Sandbox-Status.

Praktische Anwnedung

Eine Edge-3.0-Umgebung wird beispielsweise bereits von einem Telekommunikationskunden genutzt, der so virtuelle Netzwerkfunktionen mit Standard-Hardware in einer verteilten Architektur realisiert. Die größere Flexibilität bei der Hard- und Software-Auswahl führte hier zu erheblichen Kostensenkungen.

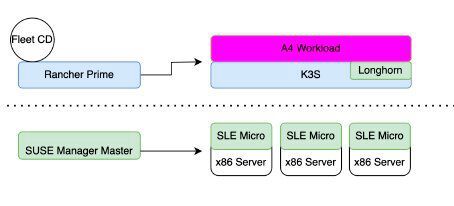

Beim Edge-Management werden hier zwei Ebenen kombiniert: Der „Suse Manager Master“ verwaltet SLE Micro und die Serverhardware, Rancher Prime mit Fleet Kubernetes, Longhorn und Workloads. Zusammengebunden wird beides über „Salt“. Das ist ein Phython-basiertes Open-Source-Tool für die Automatisierung von IT-Umgebungen.

(ID:49802290)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/70/9b701d17f9947da98f7ff66794de1c40/0118171949.jpeg)

:quality(80)/p7i.vogel.de/wcms/1b/90/1b90e93ba52866a4520b86a925993f29/0117406981.jpeg)

:quality(80)/p7i.vogel.de/wcms/a6/36/a636fe064793ade70e7c90d9399a538d/0117657802.jpeg)

:quality(80)/p7i.vogel.de/wcms/98/1b/981b9520fd3ed77b1db64bb37cfc0f81/0117922410.jpeg)

:quality(80)/p7i.vogel.de/wcms/a0/db/a0db295ab12eacca549e71cba078357c/0108524470.jpeg)

![„Ressourcen zum Wissensaufbau [rund um Cloud Native] gibt es erstmal genug. Das wichtigste ist, glaube ich, ein aufrichtiges Interesse und das Wollen“, konstatiert Max Hille im Dev-Metal-Podcast. (Bild: Vogel IT-Medien / Cloudflight) „Ressourcen zum Wissensaufbau [rund um Cloud Native] gibt es erstmal genug. Das wichtigste ist, glaube ich, ein aufrichtiges Interesse und das Wollen“, konstatiert Max Hille im Dev-Metal-Podcast. (Bild: Vogel IT-Medien / Cloudflight)](https://cdn1.vogel.de/wn4z_Ut4eM9FMQWpNr19rQyzndY=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/89/54/89548254b1bad25c375bbe4497bd614e/0118326747.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/73/5373f7073941b80f759d0ba5af02d122/0118064832.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f8/5ff8b33a74c400cae216d0256d7e6d85/0117562724.jpeg)

:quality(80)/p7i.vogel.de/wcms/2e/72/2e7289e13f9938285540e96be53cc098/0117654091.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/26/7a26ccac018032f39646084535d08b71/0118315576.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/6d/f76d249a97c8c0a91983ab137df5a078/0117977628.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/0e/fb0ec038774b9939f8180f811b62645d/0118117596.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/0c/1a0c9c9c536e5664ae5d2bb123b89870/0117497971.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/68/656863dbcf3d9/logo-devops-windhoff-group.png)

:quality(80)/p7i.vogel.de/wcms/53/1d/531d0dcb386110ebe63ada0685b25f54/0112356088.jpeg)

:quality(80)/p7i.vogel.de/wcms/3a/86/3a861660380c36be8f5c30437efc7f0c/0115482665.jpeg)