CI/CD mit GitHub und AWS CodePipeline, Teil 2 Node.JS-App per CLI auf Elastic Beanstalk bereitstellen

Früher oder später wollen wir einen GitHub-Workflow für unsere Node.js-App einrichten. Vorher schauen wir uns aber an, wie sich eine Beanstalk-App über die AWS- bzw. die Elastic-Beanstalk-Kommandozeile bereitstellen können.

Mit AWS Elastic Beanstalk (EB) lässt sich eine App in einer entsprechenden Laufzeitumgebung bereitstellen. Wie bereits mehrfach beschrieben, erstellt Elastic Beanstalk vollständig verwaltetet „Umgebungen“, die dann wiederrum z. B. ein EC2-Cluster und die zugehörige Infrastruktur verwalten.

Ob Node.js, .NET oder Docker: Der Workflow zum Bereitstellen einer App in einer vorhandenen Elastic-Beanstalk-Umgebung ist – unabhängig von der Laufzeitumgebung – immer derselbe. Im vorherigen Artikel haben wir gezeigt, wie man eine Elastic-Beanstalk-Anwendung über die Weboberfläche der AWS Management Console bereitstellt. Das Bereitstellen neuer Versionen der Anwendung lässt sich dann mit Hilfe von AWS CodePipeline orchestrieren.

Elastic Beanstalk verfügt allerdings auch über eine mächtige Kommandozeile in der Azure CLI. So wird z. B. beim Ausführen von „eb deploy“ die Anwendung komprimiert und in einen S3-Bucket hochgeladen, der dann von Ihrer Elastic-Beanstalk-Umgebung abgerufen wird.

Ist die Runtime beispielsweise Docker, erwartet Beanstalk, eine Docker-Datei im Stammverzeichnis Ihres Projektverzeichnisses zu finden. Ist dies der Fall, erstellt der Service das Image in einer der EC2-Instanzen des EC2-Clusters, bevor es als Container ausgeführt wird. Ist die Laufzeit hingegen Node.js, Java, PHP, Python oder .NET, wird der Code direkt ausgeführt.

Wie können wir das Ganze nun aber per Command Line Interface (CLI) automatisieren und mit einer CI/CD-Pipeline verknüpfen? Zur Nutzung von „eb deploy“ muss das EB CLI installiert und konfiguriert sein. Die Installation ist relativ einfach und in der AWS-Dokumentation gut beschrieben. In Kürze:

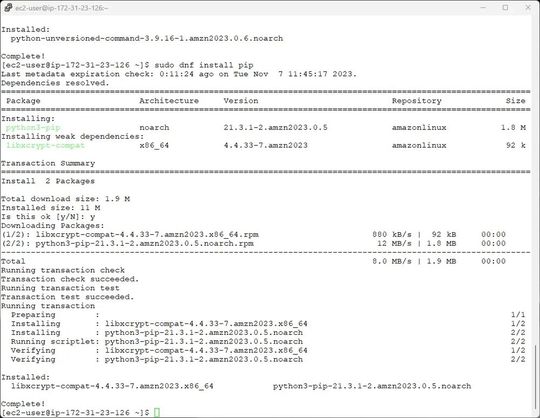

1. Python und Pip installieren

sudo dnf install python

sudo dnf install pip2. Anschließend die awsebcli installieren, via:

sudo pip install awsebcli --upgrade -–userDie Option „--upgrade“ sorgt dafür, dass alle bereits installierten Abhängigkeiten aktualisiert werden. Die Option „--user“ weist pip an, das Programm in einem Unterverzeichnis des Benutzerverzeichnisses zu installieren, um Änderungen an vom Betriebssystem verwendeten Bibliotheken zu vermeiden. Treten beim Versuch, die EB-CLI mit pip zu installieren, Probleme auf, lässt sich das Tool auch in einer virtuellen Umgebung installieren. Auf diesem Weg ist es möglich, das Tool und seine Abhängigkeiten zu isolieren, oder eine andere Version von Python zu verwenden.

Die dritte Option zur Installation der EB-CLI besteht darin, sich von https://github.com/aws/aws-elastic-beanstalk-cli-setup ein passendes Setup-Skript herunterzuladen, den so genannten Elastic Beanstalk CLI Installer. Allerdings erfordert dies ebenfalls eine virtuelle Umgebung (virtualenv). Unter Amazon Linux klappt das wie folgt (bei der Arbeit mit Ubuntu ist „dnf install“ durch „apt-get install“ zu ersetzen:

python -m pip install --user virtualenv

python -m virtualenv --help

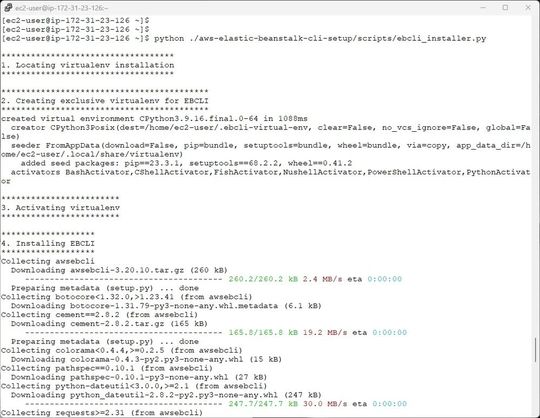

Dann installieren wir die EB-CLI über das Setup-Skript …

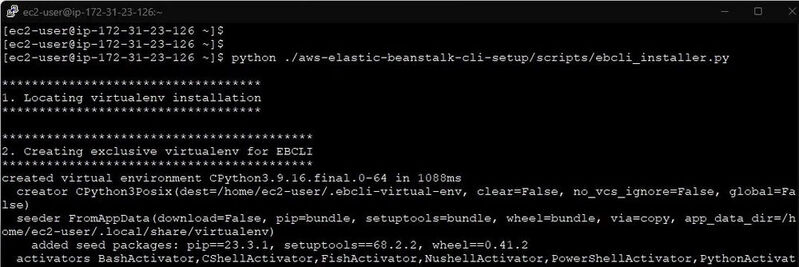

git clone https://github.com/aws/aws-elastic-beanstalk-cli-setup.git… gefolgt von …

python ./aws-elastic-beanstalk-cli-setup/scripts/ebcli_installer.pyDas Ergebnis sollte so aussehen, wie im vorangestellten Bild.

3. Es gibt mehrere Möglichkeiten, die EB-CLI zu konfigurieren (Befehlszeilenargumente, Konfigurationsdateien, Umgebungsvariablen). Wir werden hier Umgebungsvariablen verwenden. Warum? Umgebungsvariablen sind Variablen, auf die das gesamte System zugreifen kann. Sie werden häufig zum Festlegen von Parametern wie API-Schlüsseln, Anmeldeinformationen und anderen Variablen verwendet, die aus Sicherheitsgründen nicht fest codiert werden sollten.

Umgebungsvariablen lassen sich in einem Container-Image oder einem beliebigen Betriebssystem mit nur einem Befehl festlegen. Auf Plattformen wie GitHub können Sie Umgebungsvariablen als GitHub-Secrets definieren, auf die Sie über einen GitHub Actions-Runner zugreifen können, wie z. B.:

export AWS_ACCESS_KEY_ID="MY_ACCESS_KEY_ID"

export AWS_SECRET_ACCESS_KEY="MY_SECRET_ACCESS_KEY"

export AWS_DEFAULT_REGION="us-east-1"GitHub-Secrets

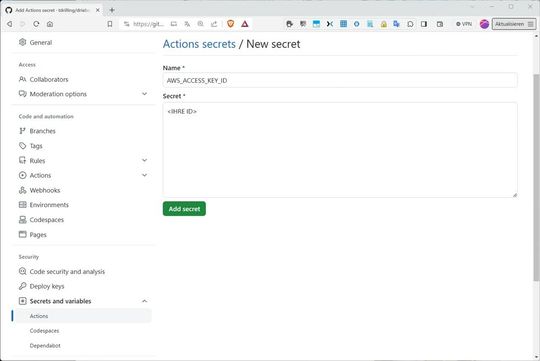

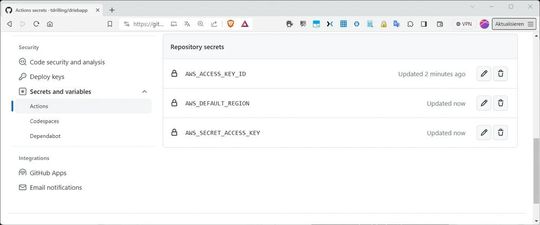

Wir wollen die Beanstalk-Anwendung in nächsten Teil dieses Beitrags mit Hilfe eines Workflows in GitHub-Actions bereitstellen. Dazu verwenden Umgebungsvariablen in unserem Workflow, welche zu diesem Zweck als so genannte GitHub-Secrets abgelegt werden. Bei GitHub-Secrets handelt es sich um eine Funktion, die über die Einstellungen des Repositorys auf GitHub verfügbar ist.

Jedes Secret ist ein Schlüssel-Wert-Paar, das verschlüsselt ist und auf das man über einen GitHub-Actions-Runner zugreifen kann. Im entsprechenden GitHub-Repository werden die Geheimnisse in den Einstellungen des Repositories konfiguriert. Hierfür wählt man auf der rechten Registerkarte „Settings“ in der linken Seitenleiste „Secrets and variables / „Actions“ aus und klickt rechts oben auf „New repository secret“. Nun legen wir nacheinander die drei erforderlichen Geheimnisse für die Interaktion von GitHub mit AWS fest, also:

AWS_ACCESS_KEY_ID

AWS_DEFAULT_REGION

AWS_SECRET_ACCESS_KEY

Die Werte finden sich in der IAM-Console. Die Secrets sind jetzt im GitHub-Actions-Workflow mit dieser Syntax zugänglich.

${{ secrets.SECRET_NAME }}

Das Ergebnis sollte etwa so aussehen, wie im vorangestellten Bild. Im Folgenden wollen wir dann eine Beanstalk-App über GitHub bereitstellen und dabei die kontinuierliche Integration mit Hilfe von GitHub-Actions einrichten.

GitHub-Actions

GitHub Actions ist eine relativ neue GitHub-Funktion, mit dem Sie ganz einfach einen CI/CD-Workflow auf GitHub ausführen können, um Ihre Änderungen zu erstellen, zu testen und bereitzustellen. Sie können dabei so genannte Workflows definieren, die immer dann ausgeführt werden, wenn ein Pull Request geöffnet oder zusammengeführt wird.

Mit GitHub Actions definieren Sie Workflows in einer YAML-Datei, die in z. B. in PROJECT_ROOT/.github/workflows/YOUR_CONFIG.yml gespeichert wird. Ein Workflow besteht aus Schritten (step), Aktionen (action) und Aufträgen (job), die in einem Runner ausgeführt werden:

- step: Ein Shell-Befehl oder eine Aktion

- action: eine benutzerdefinierte Anwendung für GitHub Actions, die wir hier nicht benötigen

- job: Eine Reihe von Schritten, die nacheinander auf demselben Runner ausgeführt werden

- runner: Die Umgebung, in der ein Auftrag ausgeführt wird, kann man sich als Container vorstellen

Hier ist ein Beispiel für einen Workflow:

name: example-workflow

on: [push]

jobs:

example-job:

steps:

- uses: actions/checkout@v2

- uses: actions/setup-node@v2

with:

node-version: '14'

cache: 'npm'

- run: npm install

- run: npm testDer Workflow heißt „example-workflow“ und enthält einen einzelnen Auftrag mit dem Namen „example-job“, der aus 4 Schritten besteht:

- 1. actions/checkout@v2 ist eine Aktion, die das Repository im Runner auscheckt - ohne diese kann Ihr Workflow nicht auf den Code in Ihrem Repository zugreifen.

- 2. actions/setup-node@v2 ist eine Aktion, die Node.js auf dem Runner einrichtet.

- 3. npm install ist ein Schritt, mit dem NPM-Abhängigkeiten installiert werden. Beachten Sie, dass npm nur verfügbar ist, weil Node.js im vorherigen Schritt installiert wurde.

npm test ist ein Schritt, der einen NPM-Befehl zum Ausführen von Tests ausführt.

Zusätzlich definiert on: [push] ein Ereignis, das bedeutet, dass der Workflow jedes Mal ausgelöst wird, wenn jemand etwas in das Repository pusht.

Im nächsten Teil wollen wir den ganzen Bereitstellungprozess automatisieren und einer CI/CD-Pipeline versehen. Im Groben sähe dann ein Bereitstellungsskript etwa so aus:

# Install Python 3.9

sudo apt-get install python3.9# Install pip

curl -O https://bootstrap.pypa.io/get-pip.py

python3 get-pip.py --user# Install the EB CLI

pip install awsebcli# Export the env variables required

# by the EB CLI

export AWS_ACCESS_KEY_ID="MY_ACCESS_KEY_ID"

export AWS_SECRET_ACCESS_KEY="MY_SECRET_ACCESS_KEY"

export AWS_DEFAULT_REGION="us-east-1"# Deploy to EB

# This command will zip up the files in the directory

# and upload the archive to S3

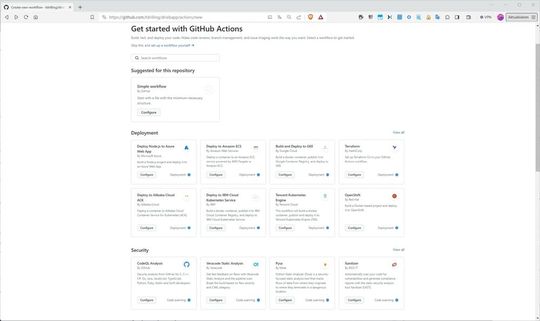

eb deployKlicken Sie im GitHub-Dashboard auf das Register „Actions“, können Sie eigene Workflows einrichten. Die Auswahl der mitgelieferten Vorlagen reicht von „Simple workflows“ mit einer einfachen Basis-Struktur bis hin zu sehr spezifischen Vorlagen für „Deployment“, „Security“, „Continous Integration“ oder „Automation“.

Im nächsten Teil werden wir uns dann intensiv mit einem passenden Workflow zum Bereitstellen einer Node-Anwendung auf einer eb-Umgebung befassen.

(ID:49833892)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/70/9b701d17f9947da98f7ff66794de1c40/0118171949.jpeg)

:quality(80)/p7i.vogel.de/wcms/1b/90/1b90e93ba52866a4520b86a925993f29/0117406981.jpeg)

:quality(80)/p7i.vogel.de/wcms/a6/36/a636fe064793ade70e7c90d9399a538d/0117657802.jpeg)

:quality(80)/p7i.vogel.de/wcms/98/1b/981b9520fd3ed77b1db64bb37cfc0f81/0117922410.jpeg)

:quality(80)/p7i.vogel.de/wcms/a0/db/a0db295ab12eacca549e71cba078357c/0108524470.jpeg)

![„Ressourcen zum Wissensaufbau [rund um Cloud Native] gibt es erstmal genug. Das wichtigste ist, glaube ich, ein aufrichtiges Interesse und das Wollen“, konstatiert Max Hille im Dev-Metal-Podcast. (Bild: Vogel IT-Medien / Cloudflight) „Ressourcen zum Wissensaufbau [rund um Cloud Native] gibt es erstmal genug. Das wichtigste ist, glaube ich, ein aufrichtiges Interesse und das Wollen“, konstatiert Max Hille im Dev-Metal-Podcast. (Bild: Vogel IT-Medien / Cloudflight)](https://cdn1.vogel.de/wn4z_Ut4eM9FMQWpNr19rQyzndY=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/89/54/89548254b1bad25c375bbe4497bd614e/0118326747.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/73/5373f7073941b80f759d0ba5af02d122/0118064832.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f8/5ff8b33a74c400cae216d0256d7e6d85/0117562724.jpeg)

:quality(80)/p7i.vogel.de/wcms/2e/72/2e7289e13f9938285540e96be53cc098/0117654091.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/26/7a26ccac018032f39646084535d08b71/0118315576.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/6d/f76d249a97c8c0a91983ab137df5a078/0117977628.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/0e/fb0ec038774b9939f8180f811b62645d/0118117596.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/0c/1a0c9c9c536e5664ae5d2bb123b89870/0117497971.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/7e/157e4a2278b04bef0c34787bbcaa32d4/0116973801.jpeg)

:quality(80)/p7i.vogel.de/wcms/62/13/62131a5810ef9eaf266c692618b5325d/0115499678.jpeg)