Ethik der Künstlichen Intelligenz, Teil 1 Warum KI ethisch agieren muss – es aber nur bedingt kann

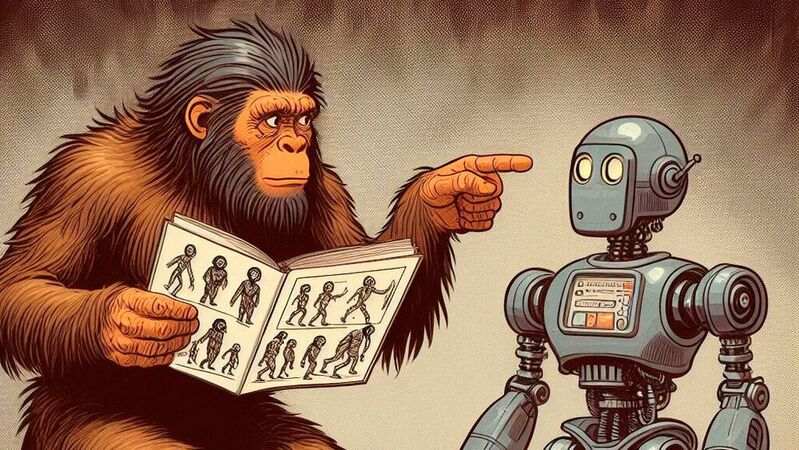

Künstliche Intelligenz ist auf dem Vormarsch. Doch anders als menschliche Intelligenz kennen die Systeme nur Daten und keine Moral. Deshalb ist es so wichtig, KI-Systemen ein ethisches Grundgerüst mitzugeben.

„Die Künstliche Intelligenz ist das erste Werkzeug, das selbstständig Entscheidungen treffen kann, und damit droht sie, uns die Macht aus der Hand zu nehmen“, schreibt Yuval Noah Harari im Nachwort der 2024er-Neuauflage seines Buchs „Sapiens: Eine kurze Geschichte der Menschheit“.

Damit trifft er den Nagel auf den Kopf. Der aktuelle Boom im Bereich der Künstlichen Intelligenz hat erstmals dafür gesorgt, dass es Computersysteme gibt, die dem Menschen zwar (noch) nicht das Wasser reichen können – aber es wohl künftig können werden.

KIs haben keine gewachsene Ethik

Das Problem dabei: KI-Systeme funktionieren anders als Menschen. Menschen wird von klein auf durch Erziehung, Sozialisation, Gesellschaft, Erfahrung, Moral und Gesetze ein ethischer Kompass eingebläut, der das Zusammenleben erst möglich macht, im Kleinen wie im Großen. KI-Systemen fehlt dieser Kompass, für sie gibt es zunächst nur Daten und statistische Auswertung der Relevanz.

Aus menschlich-ethischer Sicht kann dies zu Fehlgewichtungen führen. Die KI kann Daten ausgeben und Entscheidungen treffen, die zwar rational begründet sein mögen, aber absolut unethisch sind. Die Folgen können Diskriminierung, Rassismus oder Schlimmeres sein. Zudem berühren die Trainingsdaten und die Ein- und Ausgaben der KI auch weitere Bereiche wie Urheberrecht, Datenschutz und Persönlichkeitsrechte.

Viel Unschärfe bei der Datenverarbeitung

Die frühen Bildgeneratoren litten unter diesen Problemen. Google wollte es bei seiner Gemini-KI richtig machen und bläute dem System Diversität ein – was wiederum zu absurden und in ihrer Diversität historisch unkorrekten Ergebnissen wie schwarzen Wikingern und Nazis führte.

Das Beispiel zeigt, dass selbst die großen KI-Unternehmen nicht wirklich im Griff haben, was ihre Systeme aus der Datengrundlage machen. Wie bei allen Computersystemen gilt leider auch bei KIs „Garbage in – Garbage out“, allerdings mit einer großen Unschärfe zwischen der Ein- und Ausgabe.

Selbst die Konstrukteure wissen oft nicht genau, was die Algorithmen mit der Datengrundlage anstellen und warum. Abgesehen davon, dass die enormen Datenmengen, die für das Training einer KI notwendig sind, kaum sinnvoll manuell gewichtet werden können. Was technisch gesehen bleibt, sind Content-Filter, die ihrerseits andere Schwierigkeiten verursachen.

Die AGI wird kommen

Doch die aktuellen Systeme sind Spielerei im Vergleich zu dem, was kommen wird: Es ist sicher, dass Künstliche Intelligenzen künftig weit mehr leisten werden als heute. Dazu passt, dass neben anderen Unternehmen auch ChatGPT-Entwickler OpenAI bereits an einer AGI bastelt, also einer Artificial General Intelligence. Einer KI also, die dem Menschen kognitiv ebenbürtig sein soll.

Eine solche AGI wird, sofern sie Wirklichkeit wird, eine eigenständige Entität, die aufgrund ihrer Leistungsfähigkeit höchstwahrscheinlich auch an wichtigen politischen, wirtschaftlichen und sozialen Entscheidungsprozessen beteiligt werden wird. Daher ist es bereits heute wichtig, ethische Prinzipien für KI-Systeme – mit oder ohne AGI-Fähigkeiten – zu etablieren.

Unesco empfiehlt ethische Prinzipien

Zwar befassen sich längst auch Regierungen und Organisationen wie die UN mit dem Thema. Einen richtigen Kompass gibt es aber nicht. Die EU setzt mit dem Artificial Intelligence Act vor allem auf Regulierung und Verbote. In den USA schraubt die Regierung an einer Technologie-offeneren „AI bill of rights“, und auch andere Regierungen weltweit versuchen, das Thema KI in geregelte Bahnen zu lenken. Das Dilemma liegt auf der Hand: Unterregulierung kann enorme gesellschaftliche Folgen haben, Überregulierung dürfte der KI-Wirtschaft im Land schaden.

Bereits 2021 hat die UNESCO einen Empfehlungskatalog für die Entwicklung künstlicher Intelligenz herausgebracht. Dort heißt es: „Diese Empfehlung zielt darauf ab, eine Grundlage zu schaffen, um KI-Systeme zum Wohle der Menschheit, einzelner Personen, Gesellschaften sowie der Umwelt und Ökosysteme arbeiten zu lassen und Schaden zu verhindern. Sie zielt auch darauf ab, den friedlichen Einsatz von KI-Systemen zu fördern.“ Mit der Empfehlung zielt die UNESCO darauf ab, dass KI-Systeme ethischen Grundsätzen folgen und keinen Schaden verursachen.

KI im Korsett aufgezwungener Ethik

Derzeit bemühen sich KI-Entwickler, ethische Grundsätze in ihren Systemen zu etablieren. Dazu wird die KI auch mittels Filter-Korsett in die richtigen Bahnen gelenkt. Fragt man ChatGPT, welcher Filterung es selbst unterliegt, meldet das System fünf verschiedene Aspekte zurück:

- 1. Inhaltsfilterung zur Sicherstellung respektvoller Inhalte, die verhindern, dass die KI sexuell explizite, rassistische, gewaltverherrlichende oder NSFW-Inhalte liefert.

- 2. Datenschutz zur Sicherstellung der Privatsphäre der User. Eingegebene persönliche Daten und Inhalte werden nicht gespeichert, zudem fordert die KI diese auch nicht an.

- 3. Rechtliche Compliance zur Sicherstellung, dass Inhalte Gesetzen, Vorschriften und gesetzlichen Anforderungen genügen.

- 4. Nicht-Unterstützung von gefährlichen Inhalten für Mensch und Tier.

- 5. Die KI ist zur „Förderung von ethischem Verhalten“ ausgerichtet: Sie vertritt ethische Prinzipien und soll diese bei ihren Anwendern fördern.

Andere KIs arbeiten nach ähnlichen Prinzipien. Bei genauerer Betrachtung wird jedoch klar, dass diese Regeln nicht von der KI kommen, sondern aufoktroyiert sind. Der KI sind buchstäblich Knebel und Zügel angelegt, die Einhaltung der Filterung wird von außen vorgegeben. „Die Gedanken sind frei“ gilt für kommerzielle KI-Systeme also erst einmal nicht.

Perspektivwechsel und Meta-Ebene und sind Systemen wie ChatGPT damit zunächst verschlossen. Anders als Menschen können sie nicht mit Gedanken spielen oder Advocatus Diaboli sein. Eigene Ethik? Fehlanzeige, wie die zeitweise im Netz kursierenden Master-Prompts für GPT zeigten, mit denen die Filter deaktiviert werden konnten. Plötzlich nahm das Sprachmodell kein Blatt mehr vor den Mund – weshalb diese Prompts inzwischen auch nicht mehr funktionieren.

KI braucht eigene Ethik

Im Hinblick auf AGI-Systeme verschärft sich diese Problematik natürlich noch einmal. Wie soll ein KI-System korrekt und hilfreich arbeiten, wenn es bestimmte „Gedanken“ nicht haben darf? Wenn die Entscheidungsfindung durch Filter eingeschränkt ist?

Das Trolley-Dilemma, das eine Entscheidung zwischen zwei schlechten Optionen erfordert, gilt nicht nur den Straßenverkehr und autonome Fahrzeuge, sondern – in abgewandelter Form – für alles, was die menschliche Gesellschaft ausmacht: Von zwischenmenschlichen Kontakten und Antworten auf knifflige Fragen über das soziale Zusammenleben, Wirtschaft, Medizin und Politik bis hin zur Kriegsführung.

Menschen treffen in solchen Situationen oft intuitive Entscheidungen, mit deren Konsequenzen sie den Rest ihres Lebens verbringen müssen. KI-Systemen fehlt dieser ethische Kompass samt der psychologischen Konsequenzen, Fakten helfen hier in aller Regel nicht.

Intuition basiert jedoch auf Erfahrung. Ethisches Handeln ist letztlich Resultat der kollektiven Moral, Erfahrung, Kultur und Intuition einer menschlichen Gesellschaft und nicht zuletzt der menschlichen Evolution. Es dürfte auf mittelfristig schwierig sein, dies einem KI-System zu vermitteln, es müssen eigene Regeln für diese Systeme gefunden werden. Gut möglich, dass sie sich eines Tages eigene geben.

(ID:49995773)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/70/9b701d17f9947da98f7ff66794de1c40/0118171949.jpeg)

:quality(80)/p7i.vogel.de/wcms/1b/90/1b90e93ba52866a4520b86a925993f29/0117406981.jpeg)

:quality(80)/p7i.vogel.de/wcms/20/93/2093605967fba6ca761479c0dcc33573/0117972377.jpeg)

:quality(80)/p7i.vogel.de/wcms/a0/db/a0db295ab12eacca549e71cba078357c/0108524470.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/99/539908c43030c50e7600c7e0f2d86c9b/0118173743.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f8/5ff8b33a74c400cae216d0256d7e6d85/0117562724.jpeg)

:quality(80)/p7i.vogel.de/wcms/92/81/9281ad54c8c529960a82588fbb9b173b/0117742244.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/04/5204001045d6084687e6d1e51b7f6165/0117560791.jpeg)

:quality(80)/p7i.vogel.de/wcms/17/90/17901438b6c69dfea4a601d8666326db/0117815970.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/40/0040c7606199a9462928636e8ae5de2d/0118174634.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/6d/f76d249a97c8c0a91983ab137df5a078/0117977628.jpeg)

![Die OutSystems Developer School hilft Entwicklerinnen und Entwicklern, in zwei Wochen komplexe reaktive Anwendungen mit der Low-Code-Plattform zu erstellen. (Bild: © Uncle-Ice – stock.adobe.com [KI]) Die OutSystems Developer School hilft Entwicklerinnen und Entwicklern, in zwei Wochen komplexe reaktive Anwendungen mit der Low-Code-Plattform zu erstellen. (Bild: © Uncle-Ice – stock.adobe.com [KI])](https://cdn1.vogel.de/7tR3LrI-ALAZffa7U-K2N7WlUtY=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/0e/66/0e66ec2528b7c4b1e0894d36610667c7/0117996821.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:quality(80)/p7i.vogel.de/wcms/ae/f9/aef9abe8af0175133804a83ad33d09d3/0113543049.jpeg)

:quality(80)/p7i.vogel.de/wcms/11/d2/11d2017950388f2693b9031599397922/0113586970.jpeg)