Kostenloses Development-Tool von Facebook Code Llama – KI-gestütztes Coding mit Python und C#

Anbieter zum Thema

Code Llama ist ein neues Large Language Model des Facebook-Konzerns Meta, das auf dem von Microsoft und Meta entwickelten Open-Source-LLM Llama 2 aufbaut. Die kostenlose Lösung hilft beim Programmieren.

Mit Code Llama stellt Meta ein neues Large Language Model (LLM) zur Verfügung, das auf Llama 2 basiert und für das Schreiben von Code optimiert ist. In vielen Tests konnte Llama 2 beim Coden bereits locker mit GPT-4 mithalten, teilweise das OpenAI-LLM sogar übertreffen. Und verschiedene Tests deuten darauf hin, dass Code Llama im Generieren von Code immer besser wird. Ein Blick lohnt sich daher.

Einfach ausgedrückt hilft Code Llama dabei, auf Basis herkömmlicher KI-Prompts – also mit Anfragen in natürlicher Sprache – Code zu schreiben. Im Fokus steht dabei das Vervollständigen von Code und das Beheben von Fehlern im selbst geschriebenen Code. Allerdings ist Code Llama durchaus dazu in der Lage, komplette Code-Abschnitte selbst zu schreiben – und das vollkommen kostenlos. Generell hat Facebook das Produkt auch für die kommerzielle Nutzung freigegeben.

Dadurch ist die Lösung in der Lage, besseren Programmiercode zu entwickeln, als das mit ChatGPT möglich ist. Welche Qualität der erstellte Code besitzt, muss allerdings erst abgewartet werden. Code Llama positioniert sich generell als Alternative oder Ergänzung zu GitHub Copilot. Während Code Llama auf dem LLM-Modell Llama 2 basiert, nutzt Github Copilot das Sprachmodell GPT-4 von OpenAI. Parallel dazu arbeitet auch Amazon an einer Lösung mit der Bezeichnung CodeWhisperer. Google entwickelt derzeit an seiner Lösung AlphaCode.

Mit Code Llama schneller und fehlerfreier programmieren

Code Llama soll Entwicklern dabei helfen, schneller und fehlerfreier programmieren zu können. Außerdem soll die Lösung dabei unterstützen, den geschriebenen Programmcode besser zu dokumentieren. Das hilft später zum Beispiel beim Beheben von Fehlern oder beim Erweitern der Funktionen.

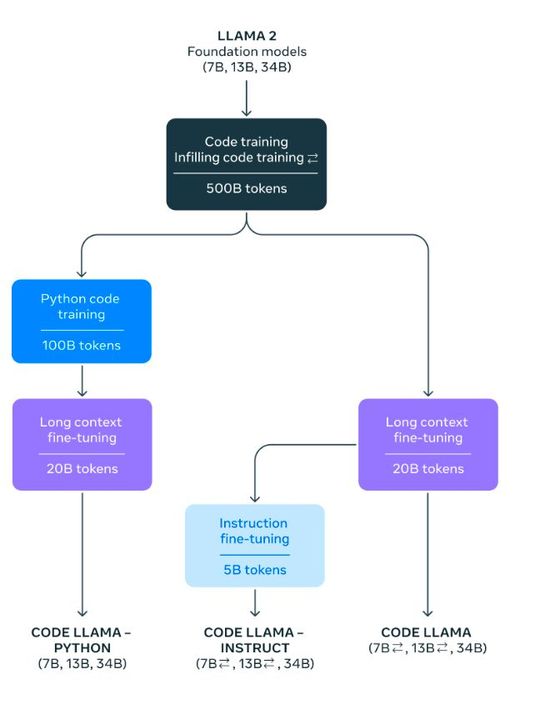

Meta hat Code Llama als eine auf Code spezialisierte Version von Llama 2 entwickelt.

Dazu wurde das vorhandene Llama-2-Modell verwendet und mit spezifischen Datensätzen zur Entwicklung erweitert. Dadurch versteht Code Llama verschiedene Programmiersprachen, darunter Python, C++, Java, PHP, Typescript (Javascript), C#, Bash und einige andere. Es ist zu erwarten, dass in Zukunft weitere Sprachen dazu kommen.

Codevervollständigung in Echtzeit

Code Llama kann bei der Erweiterung von Code helfen, aber auch komplette Codeblöcke auf Anforderung durch ein Prompt schreiben. Dabei kann komplett auf natürliche Sprache gesetzt werden. Code Llama steht in verschiedenen Größen-Varianten von 7B bis 70B zur Verfügung, wobei die Zahl für Milliarden Parameter stehen, also beispielsweise als 7 Milliarden Parameter im Falle von 7B. Jedes Modell wird mit Code und codebezogenen Daten trainiert. Die 7 Milliarden- und 13 Milliarden-Basis- und Instruct-Modelle wurden zusätzlich noch mit „fill-in-the-middle“ (FIM) trainiert. Dadurch können diese Modelle bestehenden Code verwenden und diesen erweitern.

Das 7 Milliarden Parameter-Modell unterstützt den Betrieb mit einem einzigen Grafikprozessor. Die Modelle mit 34 bzw. 70 Milliarden Parametern (34B und 70B) liefern die besten Ergebnisse und bietet eine bessere Unterstützung. Dafür dauert die Erstellung von Code aber auch länger. Die „kleineren“ Modelle 7B und 13B sind schneller und können Code mit einer sehr geringen Latenz vervollständigen, teilweise sogar in Echtzeit. Insgesamt stehen bei Code Llama daher folgende Gewichtungen zur Verfügung.

Die Modelle stehen auf der GitHub-Seite des Code-Llama-Projektes zur Verfügung. Die Größe des Downloads hängt vom jeweiligen Modell ab. Generell liegen die Download-Größen im Bereich von 13 Gigabyte (7B) bis 200 Gigabyte (70B).

Code Llama Python und Code Llama Instruct

Parallel zu den oben vorgestellten Varianten von Code Llama haben die Entwickler noch zwei weitere Varianten zur Verfügung gestellt. Mit „Code Llama – Python“ können Entwickler auf der Grundlage von 100B Token Python-Code Code erstellen.

Wenn Entwickler daher Code in Python schreiben und auf KI-Unterstützung setzen wollen, ist die Version „Code Llama – Python“ schlussendlich die am besten geeignete Variante von Code Llama. Python und PyTorch sind in der KI-Welt ohnehin beliebt und häufig im Einsatz. Daher ist ein auf Python spezialisiertes Modell in dieser Hinsicht mit Sicherheit sehr gefragt und auf jeden Fall einen Blick wert.

Die Variante „Code Llama – Instruct“ ist wiederum auf Anweisungen abgestimmt. Dieses Modell wird mit einer natürlichsprachlichen Anweisungseingabe und der erwarteten Ausgabe trainiert. Das Ergebnis ist ein besseres Verständnis dafür, was Entwickler mit ihrer Eingabe erwarten. Auf diese Weise kann es besser verstehen, was die Benutzer von ihren Eingabeaufforderungen erwarten.

Code Llama über Web-Interfaces nutzen

Natürlich ist es etwas aufwendig, selbst ein LLM herunterzuladen, einzurichten und auf einem eigenen Rechner lokal zum Laufen zu bringen. Da mitunter weit über 100 GB an Daten zusammenkommen, kann das Entwicklungsrechner schnell belasten. Die verschiedenen Größen-Varianten sind teilweise für eigene Einsatzgebiete gedacht und können sich gegenseitig nicht ersetzen. Teils benötigen Entwickler mehrere Modelle parallel.

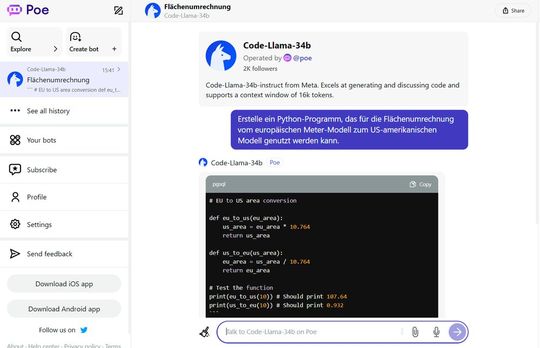

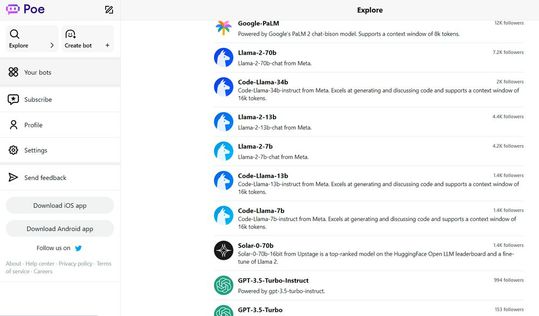

Andere Lösungen bauen allerdings die Funktionen von Code Llama in ihre Webdienste ein, zum Beispiel Poe. Hier lassen sich auch die verschiedenen Code-Llama-Modelle in der Cloud nutzen, ohne etwas lokal installieren zu müssen. Auf Perplexity stehen die Code-Llama-Modelle ebenfalls zur Verfügung, gleiches gilt im Fall von Llama 2 und Code Llama auch für die Google Cloud Vertex AI.

(ID:49774590)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/dc/80dc01258b6dda1e7b216323d5796051/0118518397.jpeg)

:quality(80)/p7i.vogel.de/wcms/b5/92/b592b98f6fa8f4d5393e7d1f26a9b1ab/0117932513.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/88/af88b8b06a9613b86559b6999ef4ed8a/0118097195.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/b3/8eb34e2abe20465041e396063e8d39b5/0118088468.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/59/d859a4bcea4e775772b78767789646e7/0117717484.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/3d/4a3d398f19b8fa2044a3a9f0081e46f2/0118416942.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/9d/f19deb033fc3094112887ccba347e548/0118171860.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/85/5b853b09ae4f974cb97b58e5cb8e759b/0118249571.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/68/656863dbcf3d9/logo-devops-windhoff-group.png)

:quality(80)/p7i.vogel.de/wcms/6d/b1/6db1a98507ab23cba4740a4b77ae74f7/0114034901.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/fc/fffca1d569d09cc99bc728e89f982c0c/0115074149.jpeg)