Es muss nicht immer Spring Boot sein Schlanke Microservices mit Pistache

Anbieter zum Thema

Die verbreitetste Implementierung von Microservices, Spring Boot in der Java Virtual Machine (JVM), ist unumstritten. Doch was hat es mit dem Trend, Java-Applikationen als Microservices umzusetzen, auf sich? Dieser Beitrag zeigt das auf und vergleicht JVM mit plausiblen Alternativen. Der Fokus liegt hier auf Pistache.

Der in den vergangenen Jahren entstandene Trend, Java-Applikationen für das Internet als Microservices umzusetzen oder bestehende Monolithen in solche zu migrieren, wird in letzter Zeit immer häufiger hinterfragt. Dafür gibt es eine Vielzahl von Gründen.

Hierzu zählen beispielsweise die in Anspruch genommenen Hardware-Ressourcen oder die resultierende Performance. Interessant sind nebst den Antwortzeiten auch die Startzeit der Applikation und deren Ressourcenverbrauch. Dabei liegt der Fokus auf dem Betrieb orchestrierter Container in einer Cloud.

Die Kommodität für den Entwickler bei der Erstellung der Software sowie die damit verbundene „Time to Market“-Geschwindigkeit stehen dem ökologischen und ökonomischen Fußabdruck des Betriebs gegenüber. Nicht zu unterschätzen ist, dass auch bei der Software-Entwicklung ein Beitrag zum nachhaltigen Umgang mit der Natur und ihren Ressourcen geleistet werden kann.

Ursprung von Java, Portabilität heute und State of the Art

Die Programmiersprache Java wurde einst mit dem Fokus auf Portabilität entwickelt. Der Marketing-Slogan „Write once, run anywhere“ von Sun Microsystems aus dem Jahre 1995 verdeutlicht dies. Diese Portabilität ist in der Cloud nicht mehr notwendig, da der Container das Betriebssystem und die Prozessorarchitektur vorgibt.

Die Kompilierung zu portablem ByteCode für die JVM erzeugt einen unnötig gewordenen Mehraufwand. Mittels GraalVM können native Binaries erzeugt werden, was dieses Problem zur Laufzeit entschärft. Was noch übrig bleibt, sind die langen Build-Zeiten und die Auswirkungen der Garbage Collection. Diese letzte Hürde lässt sich nicht so leicht lösen, da das Konzept der automatischen Speicherverwaltung stark mit der Sprache verbunden ist. Die meisten Java-Entwickler würden darauf aber kaum verzichten wollen.

Will man den Optimierungsgedanken jedoch weiterverfolgen, bietet sich eine Implementierung der Anwendung in einer Sprache wie C++ an. Die Garbage Collection und die Virtual Machine entfallen hier komplett. Die Verantwortung der Speicherverwaltung liegt dann beim Entwickler. Dank einer modernen Herangehensweise und den Möglichkeiten, welche aktuelle C++ Standards bieten, ist dies jedoch unproblematisch.

Und jetzt? Verschiedene Möglichkeiten im Vergleich

Es gibt zahlreiche, vielversprechende Bibliotheken, die in Frage kommen und getestet wurden. Das C++ REST SDK von Microsoft schien zunächst eine interessante Option zu sein, da die Bibliothek unter der MIT-Lizenz herausgegeben wird und in vielen Linux-Distributionen über zahlreiche, offzielle Linux-Repositories bezogen werden kann.

Wie sich jedoch herausgestellt hat, weist die Bibliothek eine teils problematische Performance bei der JSON-Generierung auf. Es existieren dazu unabhängige Benchmarks, welche dies deutlich aufzeigen. Der Benchmark zeigt, dass im Vergleich zwischen C++ REST SDK, restbed und Pistache, letztere Bibliothek die besten Ergebnisse aufweist. Andere, hier nicht geprüfte Alternativen wären Beast, Drogon, oat++ oder das teils kostenpflichtige POCO.

Pistache wird gegenwärtig aktiv gepflegt und lässt sich entweder aus den Quellen bauen oder im Falle von Ubuntu über ein vom Entwickler-Team gepflegtes Repository beziehen. Die Bibliothek setzt auf RapidJSON, welche derzeit eine der performantesten Implementierungen ist. Das ist entscheidend, da bei REST-Schnittstellen JSON das verbreitetste Austauschformat ist.

Pistache: Hello World!

Mit wenigen Zeilen Code ist die erste Applikation rasch geschrieben:

#include <pistache/endpoint .h>

using namespace Pistache;class HelloHandler : public Http::Handler {

public:

HTTP_PROTOTYPE(HelloHandler)

void onRequest(const Http::Request& request, Http::ResponseWriter response) override {

response.send(Http::Code::Ok, "Hello from Pistache");

}

};int main() {

Http::listenAndServe<HelloHandler>(Address (Ipv4::any(), Port (8084)), Http::Endpoint::options ());

}In der Subklasse der Http::Handler-Klasse muss die onRequest-Methode implementiert werden. Einfache Handler wie oben können das Makro HTTP_PROTOTYPE einsetzen, welches sich um die Definition der abstrakten (pure virtual) clone-Methode kümmert. In der main-Methode (dem Einstiegspunkt eines jeden C++-Programms) wird listenAndServe aufgerufen und Address – welche hier den Port beinhaltet – sowie Option – das beispielsweise die Anzahl Threads oder Größenbeschränkungen für Anfragen und Antworten beinhalten könnte – mitgegeben.

Es empfiehlt sich, das Projekt mit CMake aufzusetzen. Ein entsprechendes Beispiel dafür und sämtliche im Dokument erwähnte Codes können im Repository eingesehen werden. Der Test im Browser mit der URL localhost:8084 zeigt nach Kompilation und Ausführung das Ergebnis:

Hello from PistacheDocker

Damit die Applikation in der Cloud orchestriert verwendet werden kann, ist ein Docker-Image die Grundlage. Basierend auf dem schlanken Alpine Linux kann das Image so aussehen:

FROM alpine:latest

RUN apk -U upgrade && apk add --no-cache git clang g++ rapidjson-dev libstdc++ meson && \

git clone https://github.com/pistacheio/pistache.git && \

cd pistache && \

meson setup build && \

meson install -C build && \

cd - && rm -r pistache && \

apk del --no-cache --purge g++ clang mesonCOPY . pistache

RUN apk add --no-cache --purge g++ clang cmake make && \

export CXX=clang++ && export CC=clang && \

cd pistache && mkdir build && cd build && \

cmake .. -DCMAKE_BUILD_TYPE=Release && \

make && \

mv pistachedemo /usr/bin/pistachedemo && \

cd ../.. && rm -r pistache && \

apk del --no-cache --purge g++ clang cmake make

CMD ["pistachedemo"]

EXPOSE 8084 8084Pistache wird mit dem Build-System Meson gebaut und installiert. Es wurde sichergestellt, dass die beiden RUN-Abschnitte die nicht mehr verwendeten Abhängigkeiten wieder freigeben, um das resultierende Image so klein wie möglich zu gestalten.

Vergleich mit anderen Technologien

Gegenwärtig sind Spring Native und Quarkus in der GraalVM sowie die Implementierung in der Programmiersprache Go zusammen mit dem GIN-Framework plausible Alternativen zu der wohl verbreitetsten Implementierung von Microservices mit Spring Boot in der JVM. Um einen objektiven Vergleich der verschiedenen Varianten erstellen zu können, wurde jeweils ein Endpunkt erstellt, welcher Primzahlen bis zu einem bestimmten Limit berechnet und die Anzahl der Resultate als JSON zurückgibt. Dafür wurde das Sieb von Atkin als Berechnungsgrundlage verwendet. Sämtlicher Code ist im erwähnten Repository zu finden.

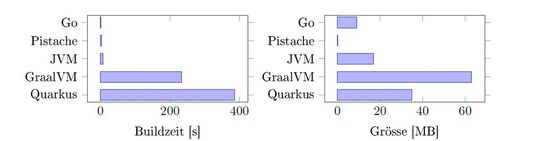

Build

Beim Vergleich der Build-Zeiten gewinnt ganz klar Go, der ungefähr in einer Sekunde baut. Gefolgt von der Umsetzung in C++. Das Erstellen der ausführbaren Dateien aus dem Java-Code ist sehr zeit- und arbeitsspeicherintensiv. Während des Build-Prozesses, der mehrere Minuten dauert, werden über 6 Gigabyte (GB) RAM vom Host in Anspruch genommen. Im CI/CD-Umfeld und einem bestimmten Volumen an Projekten, könnte dies ein ernstzunehmendes Problem darstellen.

Performance

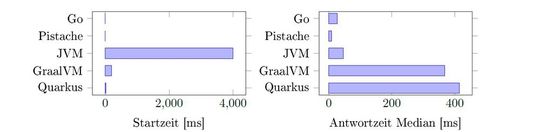

Mit der Startzeit wird die Zeit vom Starten der Applikation bis zum Verarbeiten des ersten Requests gemessen. Sowohl Pistache als auch Go starten in weniger als einer Millisekunde. Quarkus und Spring Native benötigen etwas mehr Zeit, liefern jedoch deutlich bessere Ergebnisse als das Starten der SpringBoot-Applikation in der JVM.

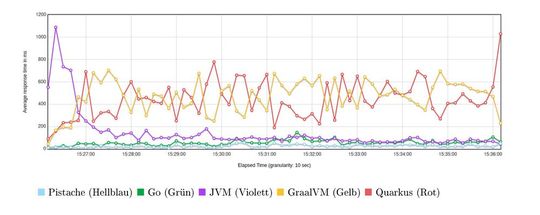

Bei den Antwortzeiten bleibt Pistache ungeschlagen. Gegenüber Go antwortet Pistache im Test in der Hälfte der Zeit. Zur Laufzeit verhält sich die SpringBoot-Applikation, was die Performance angeht, nicht schlecht. In der vorngestellten Grafik zeigt sich, dass die Ergebnisse besser werden, je länger die Applikation betrieben wird. Leider sehen die Ergebnisse bei den GraalVM-basierten Microservices weniger gut aus.

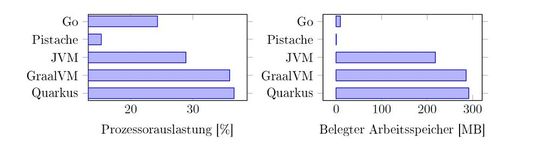

Ressourcen

Die C++-Implementierung geht wie erwartet besonders schonend mit den Ressourcen um und hebt sich deutlich von den verglichenen Java-Umsetzungen und der Go-Applikation ab.

OpenAPI

Von offizieller Seite gibt es Unterstützung für Pistache im Swagger-Codegen-Tool, welches auch direkt in SwaggerHub ausgeführt werden kann. Dazu gibt es das Profil pistache-server, um den Server-Stub zu erzeugen. Der generierte Code enthält Templates, welche dann implementiert werden müssen, wie das bei allen anderen Sprachen und Frameworks der Fall ist.

Ebenso ist es möglich, die Definition aus bestehendem Code zu generieren. Dafür wird die Definition Klasse verwendet und damit ist die Request-Beschreibung sichergestellt. Die Beschreibung der DTOs, welche zurückgeliefert werden, gestaltet sich allerdings schwieriger. Wer aus dem Java-Umfeld gewohnt ist, dass die entsprechenden Klassen einfach mit Annotationen versehen werden können, wird hier eine große Enttäuschung erleben.

Mangels Reflection bei C++ ist dies leider nicht so einfach möglich. Es ist dennoch empfehlenswert, den Microservice auf der Definition aufzubauen. Es werden der Pfad, der MIME-Type und entsprechende Beschreibungen wie nachfolgend gezeigt definiert. Zudem wird über die bind-Methode die effektive Implementierung angebunden. Im nachfolgenden Beispiel ist die Initialisierung in eine Methode ausgelagert worden:

void createDescription() {

description.route (description.get("/"))

.bind(&Server::hello)

.produces(MIME(Text, Plain))

.response(Http::Code::Ok, "HelloWorld!"); description.route(description.get("/primes"), "Calculate primes")

.bind(&Server::primes)

.produces(MIME(Application, Json))

.parameter<Rest::Type::Integer>("limit", "Limit of the calculation")

.response(Http::Code::Ok, "Total and list of primes");

}Im gezippten Beispiel sind es die Methoden hello und primes, in welchen die Request-Abwicklung stattfindet. Es wird darin schließlich die send-Methode vom ResponseWriter aufgerufen. Die gezeigte Definition wird einer Router-Instanz der initFromDescription übergeben. Daraus kann dann der Handler für den HttpEndpoint gesetzt, bevor dieser gestartet wird. Letzterer muss zuvor initialisiert worden sein.

void start() {

router.initFromDescription(description);

httpEndpoint.setHandler(router.handler());

httpEndpoint.serveThreaded();

}Fazit

Schonender Umgang mit Ressourcen und hohe Performance müssen keine Gegensätze sein, wie im Vergleich deutlich aufgezeigt werden konnte. Soll ein Microservice effizient und sparsam umgesetzt werden, ist Pistache ganz klar eine sehr interessante Option, mit der auch ein bescheidener Beitrag zum Schutz der Umwelt geleistet werden kann.

Gerade für kleine Anwendungen mit geringer Komplexität ist die Technologie besonders geeignet. Erwähnenswert ist zudem, dass Promises/A+ für die Verarbeitung für JavaScript Promises von Pistache unterstützt werden.

Nebst der erschwerten Generierung von umfangreicher API-Dokumentation, muss jedoch ein weiterer Schwachpunkt erwähnt werden: Es handelt sich dabei um die bestehende Dokumentation von Pistache, die stark zu wünschen übriglässt. Bis auf wenige Implementierungsbeispiele ist zum heutigen Zeitpunkt kaum etwas vorhanden.

Fairerweise muss aber auch berücksichtigt werden, dass der 1.0-Meilenstein der Bibliothek noch nicht erreicht wurde. Gemäß README im Github-Repository von Pistache ist der produktive Einsatz als Server jedoch bereits möglich. Im Client-Teil, welcher dieser Artikel nicht behandelt, scheint es noch Probleme zu geben. Man darf also gespannt sein, was man in Zukunft noch von Pistache hören wird.

* Eduardo Hahn Paredes ist Team Leader und Backend-Entwickler bei der adesso Schweiz AG. Er hat 20 Jahre IT-Erfahrung in zahlreichen Technologien. In den vergangenen Jahren lag sein Fokus hauptsächlich auf Spring Boot und OpenShift.

(ID:47717050)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/dc/80dc01258b6dda1e7b216323d5796051/0118518397.jpeg)

:quality(80)/p7i.vogel.de/wcms/b5/92/b592b98f6fa8f4d5393e7d1f26a9b1ab/0117932513.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/88/af88b8b06a9613b86559b6999ef4ed8a/0118097195.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/b3/8eb34e2abe20465041e396063e8d39b5/0118088468.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/59/d859a4bcea4e775772b78767789646e7/0117717484.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/c5/eec54cec9c7a219a3ed62042db71e084/0118151065.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/9d/f19deb033fc3094112887ccba347e548/0118171860.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/2e/72/2e7289e13f9938285540e96be53cc098/0117654091.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/85/5b853b09ae4f974cb97b58e5cb8e759b/0118249571.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:quality(80)/p7i.vogel.de/wcms/ba/63/ba6371225cdcba0355a39ed45cf411f7/0115111961.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)