Azure OpenAI für Entwickler, Teil 2 Azure OpenAI mit REST-API und SDK

Anbieter zum Thema

Azure OpenAI stellt eine REST-API für die Interaktion und zum Generieren von Antworten bereit. Diese können Entwickler nutzen, um Anwendungen KI-Funktionen hinzuzufügen. Wir zeigen im Folgenden, wie sich komfortabel mit REST-API und Software Development Kits arbeiten lässt.

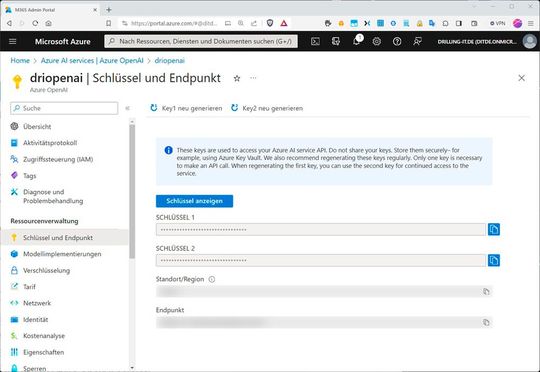

Bevor eine Interaktion mit der API möglich ist, müssen wir eine OpenAI-Ressource im Azure-Portal erstellen, dort das Azure OpenAI Studio aufrufen, darin ein Modell bereitstellen und dann den Endpunkt und die zugehörigen Schlüssel abrufen. Schlüssel und Endpunkte finden sich in der Azure-OpenAI-Ressource u. a. unter „Ressourcenverwaltung / Schlüssel und Endpunkt“:

Für jeden Aufruf der REST-API werden jeweils der Endpunkt, ein Schlüssel aus der Azure OpenAI-Ressource und der für das bereitgestellte Modell verwendete Name benötigt. Das lässt sich einfach ausprobieren: Wurde ein Modell in einer AOAI-Ressource bereitgestellt, kann man im Falle des Modells vom Typ „Completion“ mit Hilfe einer HTTP-POST-Anforderung eine „Aussage“ an den Dienst senden. Dabei ist „completion“ der Endpunkt, der für Vervollständigungen zuständig ist.

Zum Senden der REST-Anforderung empfiehlt sich ein beliebiges geeignetes Werkzeug, wie z. B. „Postman“ oder die Development-Tools des favorisierten Browsers. Eine HTTP-POST-Anfrage wie …

curl https://<your endpoint>.openai.azure.com/openai/deployments/<your deployment>/chat/completions?api-version=2023-03-15-preview \

-H "Content-Type: application/json" \

-H "api-key: <your_api_key" \

-d "{

\"prompt\": \"Your favorite Shakespeare is\",

\"max_tokens\": 5

}"… sollte ein vergleichbares JSON-Ergebnis wie das Folgende liefern:

{

"id": "<id>",

"object": "text_completion",

"created": 1679001781,

"model": "text-davinci-003",

"choices": [

{

"text": "Hamlet",

"index": 0,

"logprobs": null,

"finish_reason": "stop"

}

]}Die zu suchende Vervollständigungsantwort findet sich innerhalb von „choices[].text“. Bemerkenswert ist, dass die Antwort auch „finish_reason“ enthält, was in diesem Beispiel „stop“ ist. Eine andere Möglichkeit für „finish_reason“ wären „in length“. Das würde bedeuten, dass der in der Anforderung angegebene Wert für „max_tokens“ überschritten ist. Ein „content_filter“ als Grund würde bedeuten, dass das System von der Äußerung generierte schädliche Inhalte erkannt hat. Ist das Fall, gibt die API-Anforderung einen Fehler zurück.

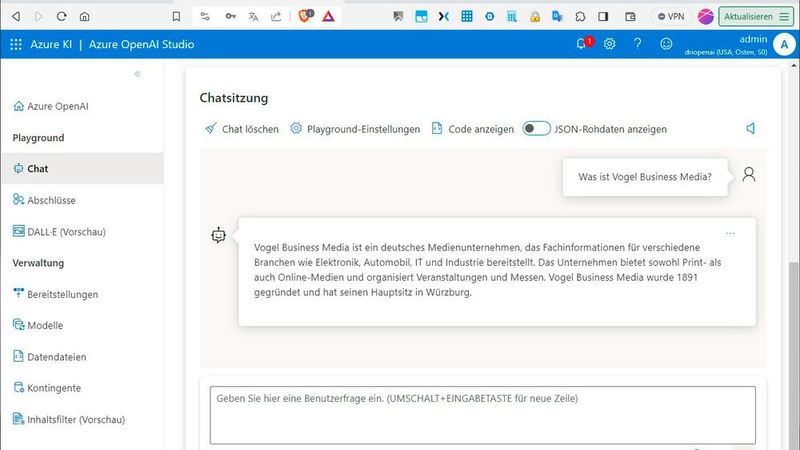

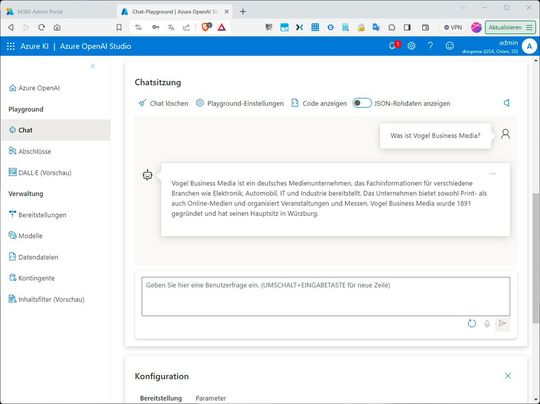

„Normale“ Vervollständigungen sind sicher interessant, viele Entwickler und Entwicklerinnen sind aber wohl mehr an einer Chat-Integration in ihre Anwendung interessiert. Anstelle von „completions“ verwenden sie in ihrer Anforderung dann „chat/completions“. Wer mag, kann das auch vorab im „Playground“ des Azure-OpenAI-Studios ausprobieren.

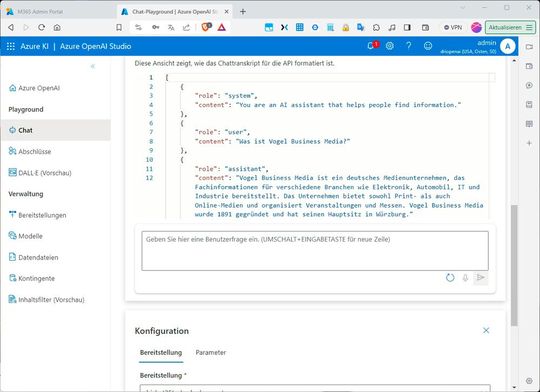

Der Playground im Azure OpenAI-Studio ist vielseitig. Beispielsweise können wir hier auf „JSON-Rohdaten anzeigen“ klicken, um selbige sichtbar zu machen.

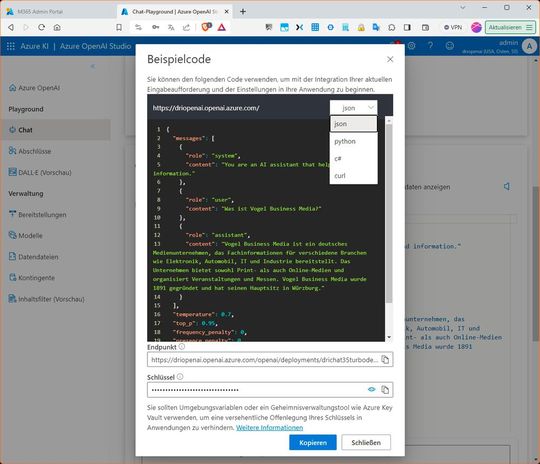

Alternativ können wir schauen, was passiert, wenn der Schieber bei „Code anzeigen“ bestätigt wird. Das Tool zeigt dann den Quellecode für „json“, „python“, „c#“ oder „curl“ entsprechend der Auswahl rechts oben. Außerdem findet sich unten den zuständigen Endpunkt, wie in unserem Beispiel „https://driopenai[...]?api-version=2023-07-01-preview“ und den zugehörigen Schlüssel.

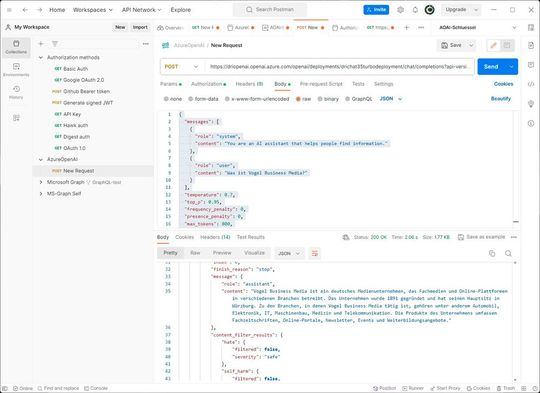

Das Tolle dabei ist, dass sich die benötigen Werte hier bequem kopieren lassen, falls man beispielsweise REST-Anfragen mit einem anderen Werkzeug, wie z. B. den Entwicklertools des Browsers oder mit Postman, an den Endpunkt senden möchte. In Postman sähe das etwa so aus, wie im vorangestellten Bild.

Den benötigten Endpunkt kennen wir ja bereits und können ihn oben im Anfrage-Feld eintragen. Als HTTP-REST-Methode verwenden wir „POST“. Der API-Schlüssel lässt sich im Tab „Authorization“ als Bearer-Token hinterlegen. Den übrigen Quellcode fügen wir im Tab „Body“ im „raw“-Format ein. Der „Typ“ wird in der Werkzeugleiste des Body-Tabs rechts oben auf „JSON“ eingestellt. Auf die gleiche Weise können wir nun weitere Fragen an den Dienst senden und damit das Code-Fragment für unsere Anwendung testen und optimieren.

OpenAI-SDK nutzen

Ergänzend zu den REST-APIs können wir auch über die Python- oder C#-SDKs auf Azure-OpenAI-Modelle zugreifen mit der gleichen Funktionalität. Dazu gilt es lediglich die erforderlichen Bibliotheken zu installieren.

Beim C#-SDK handelt es sich um eine .NET-Adaptation der REST-APIs, die von Microsoft speziell für Azure OpenAI entwickelt wurde. Das SDK kann allerdings nicht nur zum Herstellen einer Verbindung mit Azure-OpenAI-Ressourcen verwendet werden, sondern auch für Nicht-Azure-OpenAI-Endpunkte. Das Python-SDK hingegen wird exklusiv von OpenAI entwickelt und verwaltet. Ersteres stellen wir daher mit …

dotnet add package Azure.AI.OpenAI –prerelease… zur Verfügung. Die Konfiguration ist für die jeweiligen Sprache leicht unterschiedlich. Jedoch müssen wir für beide letztlich die gleichen Parameter festlegen, nämlich „endpoint“, „key“ sowie den Namen des „Deployments“, welcher beim Senden der Eingabeaufforderung an das Modell als „engine“ bezeichnet wird. Nun gilt es noch, der Applikation die Bibliothek hinzuzufügen und die für den Client erforderlichen Parameter festzulegen. In C# sähe das dann so aus (Quelle Microsoft):

// Add OpenAI library

using Azure.AI.OpenAI;// Define parameters and initialize the client

string endpoint = "<YOUR_ENDPOINT_NAME>";

string key = "<YOUR_API_KEY>"; //SDK calls this "engine", but naming it

// "deploymentName" for clarity

string deploymentName = "<YOUR_DEPLOYMENT_NAME>";

OpenAIClient client = new OpenAIClient(new Uri(endpoint), new AzureKeyCredential(key));Wurde eine Verbindung mit Azure OpenAI konfiguriert, ist es möglich, eine Eingabeaufforderung an einen der verfügbaren Endpunkte von Completion, ChatCompletion oder Embedding zu senden.

string prompt = "What is Azure OpenAI?";

Response<Completions> completionsResponse = client.GetCompletions(deploymentName, prompt);string completion = completionsResponse.Value.Choices[0].Text;Console.WriteLine($"Chatbot: {completion}");Das Antwort-Objekt enthält dann mehrere Werte, wie z. B. total_tokens und finish_reason. Die Bedeutung haben wir oben erklärt.

(ID:49870044)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/dc/80dc01258b6dda1e7b216323d5796051/0118518397.jpeg)

:quality(80)/p7i.vogel.de/wcms/b5/92/b592b98f6fa8f4d5393e7d1f26a9b1ab/0117932513.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/88/af88b8b06a9613b86559b6999ef4ed8a/0118097195.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/b3/8eb34e2abe20465041e396063e8d39b5/0118088468.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/59/d859a4bcea4e775772b78767789646e7/0117717484.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/3d/4a3d398f19b8fa2044a3a9f0081e46f2/0118416942.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/9d/f19deb033fc3094112887ccba347e548/0118171860.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/17/da/17dafb2a1af44f861d791dda292b219b/0118430756.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/85/5b853b09ae4f974cb97b58e5cb8e759b/0118249571.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/68/656863dbcf3d9/logo-devops-windhoff-group.png)

:quality(80)/p7i.vogel.de/wcms/b1/90/b19062162dde8054fda9e93734bd5436/0116010625.jpeg)

:quality(80)/p7i.vogel.de/wcms/84/a8/84a86fa6a26e6f716d7f1af2de7a6d5e/0116223185.jpeg)