Einführung in Azure AI Services, Teil 4 Gesichtserkennung mit Azure AI Vision

Anbieter zum Thema

Mit der Bilderkennung und Bildanalyse im Rahmen der Azure KI-Services haben wir uns bereits grundlegend befasst. In diesem Artikel schauen wir noch einmal gezielt auf das Feature Gesichtserkennung.

Wie schon im vorherigen Artikel zu den verschiedenen Azure-AI-Diensten erläutert, vereint das KI-Thema unterschiedliche Aspekte. Für Datenwissenschaftler stehen mathematisch-wissenschaftliche Gesichtspunkte im Vordergrund. Aus Sicht von Entwicklerinnen und Entwicklern steht die Modellierung von künstlicher Intelligenz in Software im Vordergrund. Admins hingegen benötigen Kenntnisse über das Portfolio der Azure-KI-Dienste einschließlich der verfügbaren Werkzeuge, wie z. B. dem Azure Vision Studio oder der von Azure bereitgestellten API.

Möchten Sie als Unternehmen entsprechende KI-Dienste in ihre Produkte integrieren, müssen alle diese Fachkräfte zusammenarbeiten. Dieser Beitrag befasst sich mit der Perspektive von Entwicklungsteams. Wir nutzen aber zunächst das Vision Studio, um die Arbeitsweise und Leistungsfähigkeit der von Microsoft bereitgestellten, vortrainierten Modelle zur Gesichtserkennung auszuprobieren.

Zunächst ein paar Grundgedanken zur KI-gestützten Gesichtserkennung. Gemeint ist damit das Identifizieren von Regionen eines Bildes, die möglicherweise ein menschliches Gesicht enthalten. Praktisch erfolgt dies in der durch Rückgabe der Koordinaten eines Begrenzungsrahmens, der ein Rechteck um das erkannte Gesicht bildet.

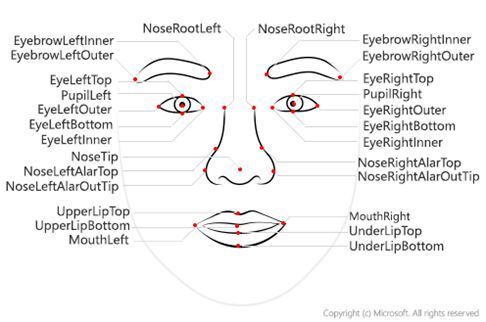

Die Gesichtsanalyse verwendet Gesichtsmerkmale, mit deren Hilfe Machine Learning-Modelle trainiert werden, um andere Informationen zurückzuliefern, z. B. Nase, Augen, Augenbrauen, Lippen oder Ähnliches. Jedes Attribut ist dabei ein Satz von Merkmalen, die durch die Azure KI Gesichtserkennungs-API erkannt werden können, wie z. B. Accessoires (Brille, Maske), Belichtung, Weichzeichnung, Kopfhaltung usw.

Die Einsatzzwecke sind vielfältig, wobei das Überprüfen der Benutzeridentität sicher der populärste ist. Häufig zum Einsatz kommt die so genannte Liveness-Erkennung. Hierbei handelt es sich um eine Anti-Spoofing-Funktion, die prüft, ob ein Benutzer physisch vor der Kamera vorhanden ist. Auch die kontaktlose Zugangskontrolle gehört zum Einsatzspektrum der Gesichtserkennung. So erlaubt die maschinelle Gesichtserkennung eine verbesserte Zugangskontrolle bei gleichzeitiger Reduzierung von Hygiene-Risiken z. B. beim Einchecken in Flughäfen, Stadien, Parks oder Schulen.

Die KI-gestützte Gesichtserkennung kann außerdem zur automatisierten Gesichtsbearbeitung eingesetzt werden, bei der z. B. in einem aufgezeichneten Video erkannte Gesichter bearbeitet oder unscharf gemacht werden, um die Privatsphäre zu schützen. Die Gesichtserkennungs-API deckt eine ganze Reihe von Algorithmen ab.

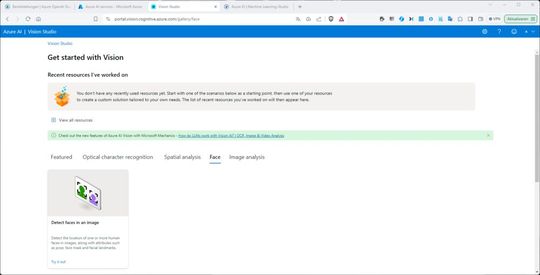

Wer die Funktion im Vision Studio ausprobieren möchte, kann in Azure wahlweise eine KI-Vision-Ressource oder eine Ressource vom Typ „multi-service-account“ erstellen. Dies erfolgt wie gezeigt über das Portal „Azure AI services“. (Link zum Vorgänger-Artikel). Danach starten wir das Azure-KI-Vision-Studio, melden uns mit einem entsprechend berechtigten Organisationskonto bei unserem Mandanten an und verknüpfen das Vision-Studio in den Einstellungen (Zahnrad oben rechts) mit der gewünschten Azure-KI-Ressource. Nun folgt auf der Startseite des Vision Studio noch ein Klick auf den Tab „Face“.

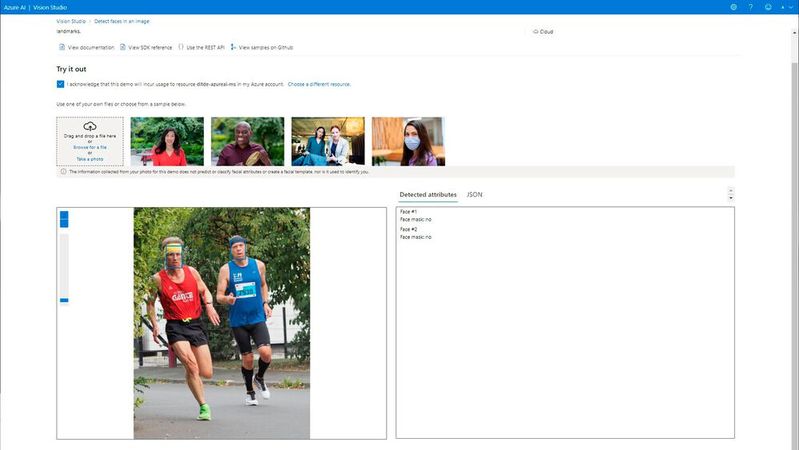

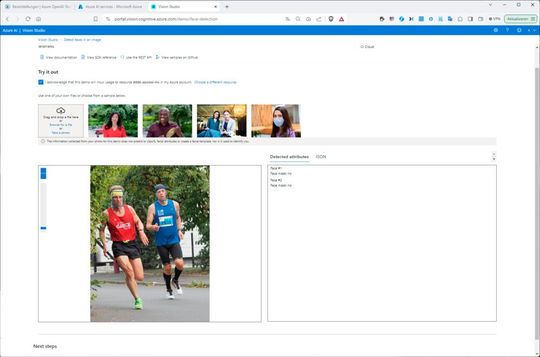

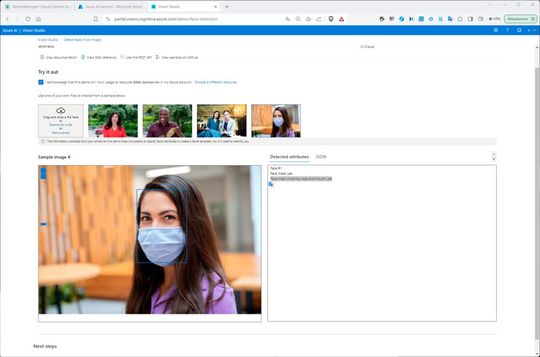

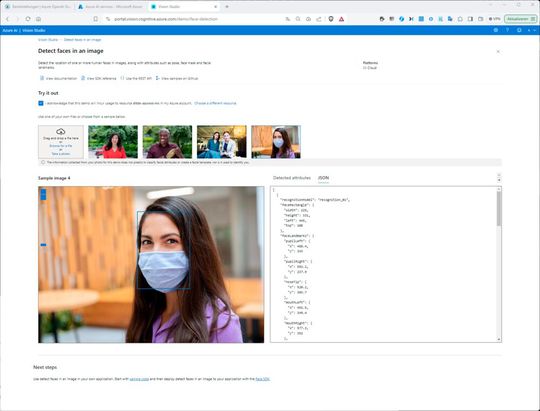

Nun klicken wir auf „Detect faces in an image“ und setzen bei „Try it out“ zunächst das Häkchen bei „I acknowledge that this demo will incur usage to resource <Name ihrer Azure-KI-Ressource> in my Azure account“. Dann laden wir bei „Drag and drop a file here“ das gewünschte Bild hoch. Das Ergebnis könnte zunächst so aussehen. Achten Sie im Tab „Detected attributes“ auf die Ausgabe. Im Beispiel wurden zwei Gesichter erkannt.

Die API zur Gesichtserkennung erkennt als Eingabebildformate JPEG, PNG, GIF (der erste Frame) und BMP. Allerdings dürfen die Bilddateien maximal 6 Megabyte (MB) groß sein. Ferner liegt die minimal erkennbare Gesichtsgröße bei 36×36 Pixel, wobei das Bild selbst aber nicht größer sein darf als 1.920×1.080 Pixel. Sind die Bilder größer, ist eine proportional größere minimale Gesichtsgröße möglich.

Das Verkleinern der Gesichtsgröße kann allerdings bewirken, dass einige Gesichter nicht erkannt werden, auch wenn sie größer als die minimal erkennbare Gesichtsbereich sind. Die maximal erkennbare Gesichtsgröße beträgt 4.096×4.096 Pixel. Nun können wir mit den mitgelieferten Beispielbildern experimentieren. Im Falle es Fotos der jungen Frau mit der FFP2-Maske wird erfolgreich eine Schutzmaske erkannt mit der Bezeichnung: „Face mask covering nose and mouth: yes“.

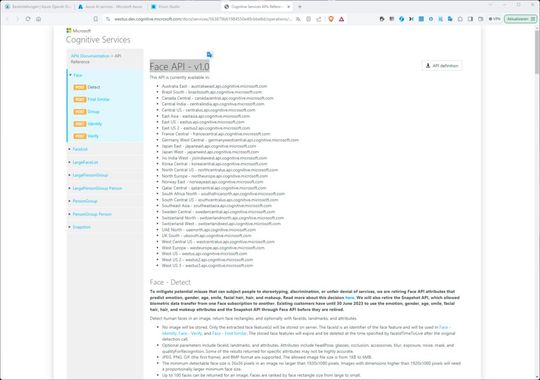

Schließlich können wir im Tab „JSON“ rechts davon auch sämtliche erkannten Attribute wie z. B. die Positionen der Rechtecke abrufen. Klicken wir nun abschließend beispielsweise oben auf den Link „Use the REST API“, verweist Sie das Studio direkt auf die Face API 1.0.

Entwicklerinnen und Entwickler können die Programmierschnittstelle also direkt im Browser erkunden. Außerdem stellt Microsoft zahlreiche Code-Beispiele für die Face-API auf GitHub zur Verfügung sowie detaillierte Quickstart-Guides mit Codebeispielen für die unterstützten Client-Bibliotheken in C#, JavaScript und Python.

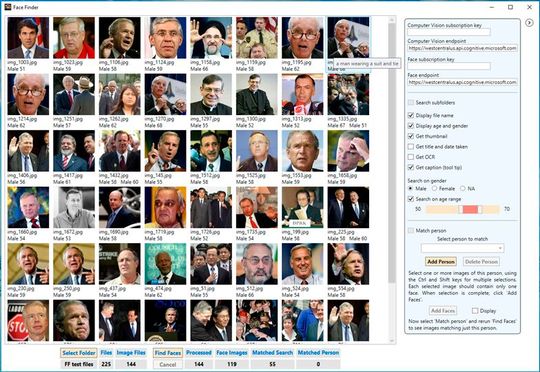

Interessant in den verlinkten Code-Beispielen ist z. B. der Face Finder, der nach Bildern mit Gesichtern in einen gegebenen lokalen Ordner sucht. Man benötigt dazu lediglich eine Azure-Subscription, eine AI-Vision-Ressource und die Entwicklungsumgebung Visual Studio.

Wier müssen dann nur das GitHub-Repository klonen und auf die Datei FaceFinder.sln doppelklicken, um das Projekt in Visual Studio zu laden. Visual Studio muss lediglich für die Entwicklung vom .NET-Desktop-Applikationen konfiguriert sein. Haben Sie das Projektfile geladen, bauen Sie das Projekt, wodurch die benötigten Computer Vision und die NuGet-Pakete für AI Vision installiert werden.

(ID:49994842)

:quality(80)/p7i.vogel.de/wcms/c8/6b/c86bfadc9400e3859e5a8173b99872db/0114956871.jpeg)

:quality(80)/p7i.vogel.de/wcms/82/e2/82e20061fab6f1fc0561f023c6bfd2cc/0114109627.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/f4/5ff47683e4bc8de6cf2d484e627c58f2/0107845613.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/d8/55d8de7a538dd09179a73c8038cf4147/0107796204.jpeg)

:quality(80)/p7i.vogel.de/wcms/80/dc/80dc01258b6dda1e7b216323d5796051/0118518397.jpeg)

:quality(80)/p7i.vogel.de/wcms/b5/92/b592b98f6fa8f4d5393e7d1f26a9b1ab/0117932513.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/88/af88b8b06a9613b86559b6999ef4ed8a/0118097195.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/b3/8eb34e2abe20465041e396063e8d39b5/0118088468.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/59/d859a4bcea4e775772b78767789646e7/0117717484.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/3d/4a3d398f19b8fa2044a3a9f0081e46f2/0118416942.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/9d/f19deb033fc3094112887ccba347e548/0118171860.jpeg)

:quality(80)/p7i.vogel.de/wcms/65/3b/653bccb0f4511868163e35e79ef17efe/0118315737.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/dd/97ddc917ccc52db20fcb3cbdebe916f1/0118360337.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/f1/bdf1217cc5885d60e2eac54ad9a69e26/0117073864.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/d1/9cd11868f7678b81932032a894bcd81a/0117948576.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/85/5b853b09ae4f974cb97b58e5cb8e759b/0118249571.jpeg)

![Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com) Mithilfe eines anderen Konsensverfahrens, Hashgraph, ließe sich eine Menge CO2 bei der Berechnung von Kryptowährungen sparen. (Bild: Benjamin ['O°] Zweig - stock.adobe.com)](https://cdn1.vogel.de/annR7MKBLjg3UGu-x3l6Nvb7-fI=/288x162/smart/filters:format(jpg):quality(80)/p7i.vogel.de/wcms/4e/40/4e40e5356b18ebce4656f2a51e65c815/0116079923.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/d0/01d02743d019010886e4fe0d47222d72/0115628204.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/59/7a595755b165e6d0939b52bc4bb82e9d/0113646230.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/18/be18ae4c02dbf9aa47e97decf9b84ea4/0118091847.jpeg)

:quality(80)/p7i.vogel.de/wcms/af/ba/afba059e1e635289905bc63ce8cc4579/0117149678.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/8a/798ac0bb2a4e3a384a3c7634dc919ceb/0117709235.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/83/ef83b21f59d76ece1f76070d93e9bd6b/0116763715.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/21/c2213857722c33ef3d02db0acf33abc0/0112236476.jpeg)

:quality(80)/p7i.vogel.de/wcms/a9/6d/a96d15ff02a35fc84a9b65702395aa6b/0110694349.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/c1/cec146c6f112e79b71c56d37ee27145e/0105884802.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/68/656863dbcf3d9/logo-devops-windhoff-group.png)

:quality(80)/p7i.vogel.de/wcms/52/04/5204001045d6084687e6d1e51b7f6165/0117560791.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/39/9939f3b5fdaae42f3bf4ac2465270f2a/0117791750.jpeg)